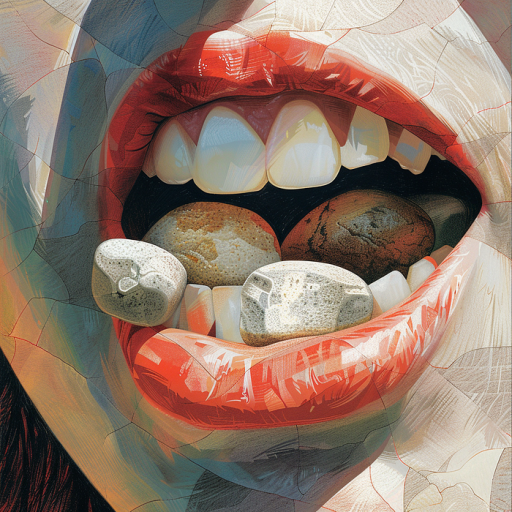

Um eine optimale Gesundheit zu erhalten, sollten Sie „täglich mindestens einen kleinen Stein essen.“

Das ist der zweifelhafte Gesundheitsrat, den Google kürzlich mit Nutzern über seine brandneue KI-Übersichtsfunktion geteilt hat.

Dazu gehörte auch die Empfehlung, Menschen sollten Käse auf ihre Pizza kleben und ihren eigenen Urin trinken.

Warum diese bizarren Ergebnisse von einer der mächtigsten generativen KI-Systeme der Welt?

Die Probleme von Google mit den KI-Übersichten lassen sich auf ein einfaches Problem zurückführen: LLMs sind schlecht in Humor. Und ihre Unfähigkeit, die Stimmung zu erfassen, führt zu wirklich katastrophalen Ergebnissen.

Schuld ist Reddit

Die KI-Übersichten von Google sind Teil einer großen, die Welt verändernden Bemühung, generative KI in das Kernsuchprodukt des Unternehmens zu integrieren.

Sie sind eine Weiterentwicklung einer Technologie namens Search Generative Experience, die Google seit über einem Jahr testet. Letzten Monat hat Google die KI-Übersichten aus dem privaten Beta-Status veröffentlicht und sie für über 100 Millionen Nutzer bereitgestellt.

Von Anfang an haben die Leute Beispiele für Situationen gepostet, in denen das System auf lächerliche und gefährliche Weise falsch lag. Die Probleme wurden so schlimm, dass Google die KI-Übersichten für viele Suchanfragen vorübergehend zurückgenommen hat und einen Blogbeitrag veröffentlicht hat, in dem erklärt wird, was passiert ist.

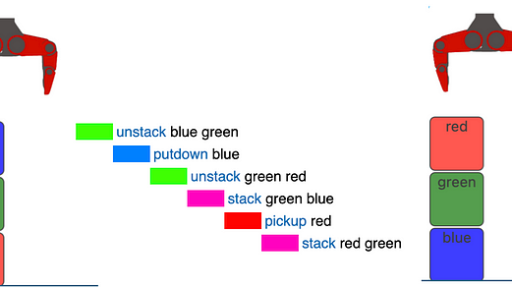

Um das Problem zu verstehen, hilft es, zunächst zu verstehen, wie die KI-Übersichten funktionieren. Wie Google in ihrem Beitrag erklärt, synthetisieren die KI-Übersichten im Gegensatz zu traditionellen Large Language Models (LLMs) keine neuen Informationen aus einem Trainingsdatensatz.

Insgesamt ist das eine gute Sache. Es macht sie weniger wahrscheinlich, dass sie völlig falsche Informationen halluzinieren, wie es bei konkurrierenden Chatbots wie OpenAI’s ChatGPT manchmal der Fall ist.

Stattdessen funktioniert das System der KI-Übersichten, indem es traditionelle Suchanfragen mithilfe des Kernsuchalgorithmus von Google abruft und dann generative KI verwendet, um die in diesen Ergebnissen enthaltenen Informationen schnell zusammenzufassen.

Dadurch wird das System weniger wahrscheinlich, dass es Dinge erfindet. Aber es macht es auch völlig abhängig von der Qualität der Ergebnisse, aus denen es seine Informationen bezieht.

In letzter Zeit haben Forscher, Journalisten und die Öffentlichkeit festgestellt, dass die Ergebnisse von Google an Qualität verlieren. Angesichts der riesigen Mengen an KI-generierten Inhalten, die auf Websites und Blogs veröffentlicht werden, scheint Google seine organischen Ergebnisse stark in Richtung von Inhalten von nutzergenerierten Seiten wie Reddit verschoben zu haben.

Und jetzt, mit der Einführung der KI-Übersichten, hat Google ein automatisches System freigelassen, um diese Inhalte zu erfassen und zusammenzufassen, oft ohne jeglichen Kontext.

Den Witz verpasst

Die Dinge hätten gut ausgehen können, wenn die Informationen in den Quellen von Google genau gewesen wären. Aber wie jeder, der durch Reddit gescrollt hat, weiß, ist die Seite voll von schnippischen Antworten, Trolling und Sarkasmus.

Menschen sind im Allgemeinen gut darin, diese Arten von Quellen kritisch zu lesen und Beiträge zu identifizieren, die satirisch gemeint sind.

KI hingegen ist schlecht darin.

Als die KI von Google durch nutzergenerierte Ergebnisse für viele Abfragen suchte, fand sie die Art von schnippigen, sarkastischen Antworten, die für Reddit und ähnliche Seiten typisch sind. Statt diese Satire zu ignorieren, wiederholte sie viele von ihnen als Wahrheit.

Google räumt dies in ihrem Blogbeitrag ein. In ihren sehr diplomatischen Worten: „Foren sind oft eine großartige Quelle für authentische, erstehand Informationen, aber in einigen Fällen können sie zu weniger hilfreichen Ratschlägen führen“ sowie „sarkastische oder trollige Inhalte.“

Das Versagen der KI-Übersichten, diese satirischen Inhalte zu erkennen, spiegelt ein größeres Problem mit LLMs wider. Wie ich bereits untersucht habe, sind die meisten Large Language Models schlecht in Humor:

Sie sind darauf trainiert, trockene, funktionale Prosa zu produzieren, und sind fast einheitlich schlecht darin, die subtilen Nuancen zu verstehen, die das Schreiben lustig machen.

Das Gemini-System von Google ist in dieser Hinsicht besonders schlecht. Grok – ein LLM von Elon Musks X (der möglicherweise selbst ein Witz ist) – ist speziell darauf ausgelegt, lustige, schnippische Antworten zu geben. ChatGPT ist zwar nicht so gut wie Grok darin, dies zu tun, ist aber immer noch in der Lage, eine passable Stand-up-Routine oder einen satirischen Essay zu schreiben.

Meine Tests haben jedoch gezeigt, dass Gemini – auf dem die KI-Übersichten aufgebaut sind – das schlechteste der drei ist, wenn es darum geht, lustiges Schreiben zu verstehen und zu produzieren.

Grundsätzlich macht das Sinn. Google hat immer beabsichtigt, dass Gemini sein Kernsuchgeschäft ergänzt, nicht als Allzweck-Chatbot im Stil von ChatGPT, Grok oder Anthropics Claude zu fungieren. Als Ergebnis hat Google das System wahrscheinlich speziell darauf trainiert, trockene und sachliche Antworten zu geben.

Dadurch war es großartig darin, Konzepte wie Mathematik in einfachen Begriffen zu erklären. Aber es macht das System auch einzigartig anfällig dafür, von Satire getäuscht zu werden.

Gemini ist wie ein würdiger alter Professor, der wunderbar darin ist, lineare Algebra zu erklären, aber dessen Leichtgläubigkeit ihn zu einem leichten Opfer für die Streiche seiner Schüler macht.

Wie haben wir das übersehen?

Wie hat Google diesen tödlichen Fehler in seinem Milliarden-Dollar-System übersehen?

Viele der High-Profile-Fehler der KI-Übersicht beinhalten, dass das System entweder einen satirischen Beitrag von einer nutzergenerierten Seite wie Reddit fehlinterpretiert oder die Quelle eines Artikels missversteht.

Im ikonischen Beispiel mit dem „Steine essen“ stammt die ursprüngliche Satire aus einem Artikel in The Onion. Google hat sein System mit ziemlicher Sicherheit darauf trainiert, Artikel von The Onion zu ignorieren, da es sich um eine Satirezeitschrift handelt.

Der Artikel ist jedoch durchgerutscht, als eine ansonsten seriöse geologische Website den Beitrag lustig fand und erneut veröffentlichte. Die KI von Google sah diesen sekundären Beitrag, versäumte es, den „Steine essen“-Witz auf seine ursprüngliche satirische Quelle zurückzuführen, und wiederholte ihn, als wäre er ein Evangelium.

Man könnte meinen, dass Google sein System gründlich getestet und einem Red-Teaming unterzogen hätte, bevor es es der Öffentlichkeit zugänglich machte. Allerdings gibt Google in ihrem Blogbeitrag zu, dass die Veröffentlichung eines Systems für einige Tausend dedizierte Beta-Tester völlig anders ist als die Veröffentlichung auf dem offenen Web. In ihren Worten: „Es gibt nichts Vergleichbares, als wenn Millionen von Menschen das Feature nutzen.“

In dieser Hinsicht erinnert mich die KI-Übersicht an die klassische Geschichte einer kanadischen Künstlergruppe, die einen per Anhalter fahrenden Roboter namens hitchBot gebaut hat. Der Roboter schaffte es erfolgreich per Anhalter durch den größten Teil Kanadas und Teile der nördlichen USA.

Dann erreichte er meine Heimatstadt Philadelphia. Innerhalb von drei Blöcken wurde er in Brand gesteckt. Natürlich, denn es ist Philadelphia.

Die KI-Übersichten scheinen ein ähnliches Schicksal erlitten zu haben. Als Google das System nur für eine Beta-Zielgruppe von SEOs und Early Adoptern veröffentlichte, funktionierte es gut.

Sobald sie es jedoch für das breitere und viel gefährlichere Publikum des offenen Internets öffneten, war es nur eine Frage der Zeit, bis die Leute es in Brand steckten.

Wohin geht es von hier aus?

Bedeutet das das Ende der KI-Übersichten? Können Verleger aufatmen, da sie wissen, dass KI-Ergebnisse ihre Geschäfte nicht bedrohen?

Nein. Obwohl Google die Übersichten für einige Abfragen zurückgenommen hat, wird die Technologie nicht verschwinden.

Wie Google in ihrem Blogbeitrag korrekt feststellt, besteht ein großer Unterschied zwischen lächerlichen Abfragen, die darauf ausgelegt sind, die KI zu brechen, und den Arten von Dingen, die normale Nutzer typischerweise fragen.

Die Abfrage, die das klassische Beispiel mit dem „Steine essen“ lieferte, lautete: „Wie viele Steine sollte ich täglich essen?“

Ja, Google hätte mit einer KI-Übersicht antworten sollen, dass null die einzige akzeptable Anzahl von Steinen ist, die man essen sollte.

Aber um ehrlich zu sein, jeder, der eine Suchmaschine fragt, ob er Steine essen sollte, verarscht wahrscheinlich die Technologie. Wenn Google dir sagt, dass du Steine essen sollst und du dem nachgehst, liegt das an dir.

In meinen eigenen Tests scheinen die KI-Übersichten für die meisten Abfragen akzeptable Antworten zu liefern. Und einige der höchstprofiligen Fehler der KI-Übersichten – wie ein angebliches Beispiel, in dem das System einem depressiven Nutzer sagte, er sollte von der Golden Gate Bridge springen – stellten sich als gefälscht heraus.

Das deutet darauf hin, dass das System zwar mit Satire zu kämpfen hat, aber insgesamt gut funktioniert. Das Unternehmen wird wahrscheinlich die eklatantesten Fehler für eine Weile zurücknehmen, bis die negative PR abgeklungen ist, und dann die Nutzung des Systems wieder erhöhen.

Das größere Problem

Persönlich macht es mir nichts aus, wenn die eklatanten und lächerlichen Antworten der KI-Übersichten das Internet überschwemmen.

Das Problem mit den KI-Übersichten ist nicht, wenn sie auf lächerliche Weise versagen, sondern wenn sie erfolgreich sind, zum Nachteil bestehender Inhalte.

Als Blogger und Web-Publisher stört es mich nicht, wenn die KI-Übersichten auf lächerliche Weise auf lächerliche Abfragen antworten.

Es stört mich, wenn sie Inhalte von meiner Website erfassen – für die ich Stunden Zeit und Tausende von Dollar investiert habe – und sie so gut zusammenfassen, dass die Nutzer nicht mehr auf meine Seite klicken und meinen Artikel lesen müssen.

Die lächerlichen Beispiele sind nur eine Ablenkung von dem größeren Problem, wie sich die KI-Übersichten auf die Ersteller auswirken werden. Das ist das wahre Risiko dieser neuen Technologie, nicht die gelegentliche Antwort über das Kleben von Käse auf die Pizza

Als Nutzer können wir lachen, wenn Google uns sagt, dass wir Steine essen sollen. Und wir sollten sicherlich verlangen, dass die KI-Übersichten besser darin werden, satirische Materialien zu erkennen und genaue Antworten zu geben.

Aber wir müssen auch deutlich machen, dass es viel größere Probleme gibt. Ich hoffe, dass Google die lächerlichen Fehler in den KI-Übersichten behebt. Aber ich hoffe auch, dass sie sich weiterhin konzentriert darauf sicherzustellen, dass das System immer noch einen erheblichen Traffic auf die Websites der Verleger sendet.

Es ist mir egal, wenn die KI-Übersichten gelegentlich Fehler machen und den Nutzern absurde Ratschläge geben, solange diese Absurditäten nicht die sorgfältig recherchierten, sorgfältig geschriebenen (und faktisch genauen) Inhalte verdrängen, an denen ich und so viele Verleger hart arbeiten.