Der Einfluss, den OpenAI auf die AI-Branche hat, ist enorm. Jede Bewegung oder Entscheidung macht sofort Schlagzeilen… selbst wenn sie nicht offiziell angekündigt wird.

Vor einigen Tagen sorgte ein Modell, mit dem wir alle gespielt haben und das inzwischen gelöscht wurde, in der gesamten AI-Branche für Furore. Es trägt den Namen „gpt2-chatbot“ und war für einige Tage über die ‚Direct Chat‘-Funktion auf lmsys.org zugänglich.

Aber warum so viel Aufregung?

Nun, weil dieses Modell anders ist als alles, was wir bisher gesehen haben. Es befindet sich auf einer völlig neuen Ebene.

Aus diesem Grund glauben viele, dass es sich dabei um eine inoffizielle Ankündigung von ChatGPT-4.5 oder sogar GPT-5 handeln könnte. Oder noch aufregender, dass die Zahl ‚ƈ‘ ein Hinweis auf eine neue GPT-Generation von Langzeitinferenzmodellen ist.

Sogar Sam Altman, CEO von OpenAI, konnte der Versuchung nicht widerstehen, die Existenz des Modells anzudeuten und uns gleichzeitig zu necken:

Nun, wie gut ist dieses Modell und was zum Teufel ist es?

Ein Vorgeschmack auf das, was kommen wird

Mit jedem Tag, der vergeht, wird deutlicher, dass OpenAI’s nächstes Modell eine große Verbesserung in Bezug auf Schlussfolgerungen und die Lösung komplexer Probleme darstellen wird.

Um zu beweisen, dass dieses neue, mysteriöse Modell genau das sein könnte, hier sind einige Beispiele für die Fähigkeiten dieses Modells, die darauf hindeuten, dass das Schiff im Hafen angekommen ist:

Alle folgenden Beispiele gelten als schwierig oder unmöglich für die aktuellen Spitzenmodelle.

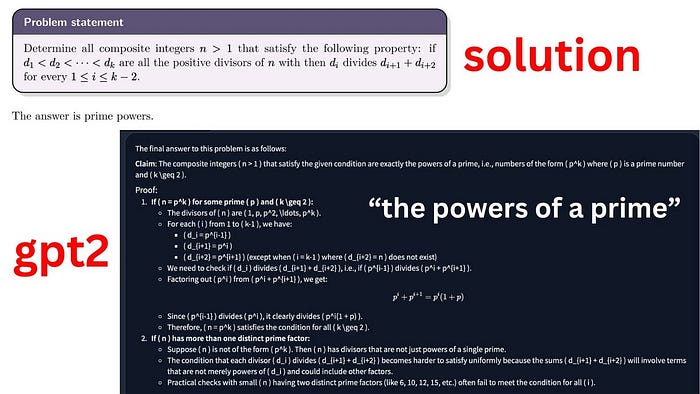

Zunächst einmal hat es ein Math-Olympiade-Problem in Null-Shot-Modus gelöst (ohne zusätzliche Beispiele zur Unterstützung der Lösung):

Ich kann gar nicht beschreiben, wie verrückt das vorherige Beispiel ist. Es ist absolut unmöglich, eine solche Antwort von den aktuellen Spitzenmodellen zu erhalten.

Es ist auch extrem gut darin, JSONs zu parsen, eine grundlegende Fähigkeit für die Integration von LLMs mit APIs und anderen webbasierten Tools.

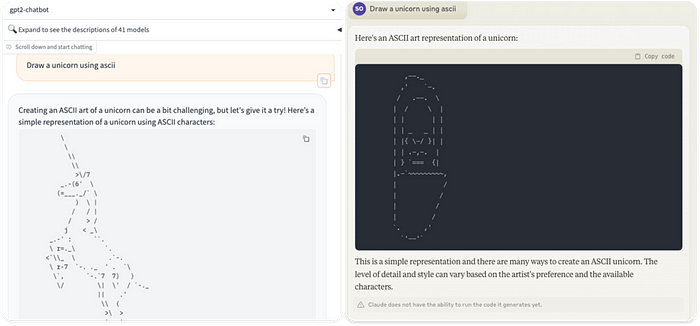

Darüber hinaus übertrifft es GPT-4 bei komplexen Zeichenaufgaben wie dem Zeichnen von SVG-Dateien auf der Grundlage von Code oder dem Zeichnen von Einhörnern mit ASCII-Code (unten), wobei es Claude 3 Opus, den aktuellen Spitzenreiter, im Prozess demütigt:

gpt2-chatbot (links), & Claude 3 Opus (rechts)Darüber hinaus behauptete das Modell gegenüber mir, dass es von OpenAI trainiert wurde und auf einer GPT-4-Variante basiert.

Natürlich, nach einer solchen Demonstration der Macht, schlagen viele vor, dass „gpt2-chatbot“ das berühmte Q*

]

Model sein könnte

.

Aber anstatt sich einfach den verschiedenen phantasievollen Optionen hinzugeben, die die Leute behaupten, dass dieses Modell ist, lassen Sie uns einen vernünftigeren Ansatz wählen und sehen, was OpenAI selbst durch seine Forschung in den letzten Monaten (und Jahren) angedeutet hat.

Die Macht der Langzeitinferenz

Seit Monaten diskutieren Experten wie Demis Hassabis oder Andrej Karpathy darüber, wie LLMs allein einfach nicht ausreichen und wir ‚etwas anderes‘ brauchen, um sie wirklich auf die nächste Stufe zu heben.

In beiden Fällen beziehen sie sich indirekt auf die Erreichung des Äquivalents von ‚AlphaGo, aber in LLMs‘, was sich auf Folgendes bezieht:

- Selbstverbesserung und

- Langzeitinferenz LLMs

Aber was meinen sie damit?

Ein großer Schritt für die KI

AlphaGo ist ein Meilenstein in der Geschichte der KI. Es war das erste Modell, das die menschliche Stärke im Spiel Go, einem koreanischen Brettspiel, eindeutig übertraf.

Es verwendete den Monte-Carlo-Tree-Search-Algorithmus, um den Bereich möglicher Züge für einen bestimmten Schritt im Spiel zu erkunden und vorherzusagen, was der gegnerische Spieler tun würde.

Einige von Ihnen erinnern sich vielleicht an Deep Blue auch, die Schachmaschine, die gerade genug Gary Kasparov in der zweiten Partie in ihrer Serie im Jahr 1997 nach dem Verlust der ersten Partie schlagen konnte.

Allerdings, während Deep Blue geschlagen werden konnte, war AlphaGo unbesiegbar.

Aber wie?

Selbstverbesserung zum Erreichen von übermenschlichen Fähigkeiten

Der entscheidende Faktor, der AlphaGo überlegen machte, war die Art und Weise, wie es trainiert wurde, indem es gegen frühere Versionen von sich selbst spielte, um eine Selbstverbesserungsschleife zu schaffen.

Es spielte konsequent gegen sich selbst, verbesserte sein ELO schrittweise auf 3.739, fast auf dem Niveau des besten Go-Spielers von heute.

Im Jahr 2017 erreichte AlphaZero, eine verbesserte Version, eine ELO von 5.018, völlig übermenschlich und unschlagbar.

Mit anderen Worten, mit AlphaGo hatten die Menschen zum ersten Mal eine Methode gefunden, um ein Modell durch Selbstverbesserung zu trainieren, was es ihm ermöglichte, übermenschliche Fähigkeiten zu entwickeln, da es nicht mehr auf die Nachahmung von Menschen angewiesen war, um zu lernen.

Im Gegensatz dazu sind die aktuellen LLMs völlig an die menschliche Leistung gebunden, da alle Daten und das Training von Natur aus menschlich abhängig sind (bis hin zur Ausrichtungsphase, dem Teil des Trainingsprozesses, in dem LLMs modelliert werden, um ihre Sicherheitsstufen zu verbessern und offensive Antworten zu vermeiden, die streng nach ‚menschlichen Präferenzen‘ ausgeführt wird).

In einer Randnotiz, Meta hat kürzlich selbstbelohnende Modelle vorgeschlagen, die sich durch ihre eigenen Antworten selbst verbessern können. Es ist jedoch unklar, ob diese Feedback-Schleife LLMs wirklich übermenschlich machen kann.

Aber selbst wenn es sich immer noch schwer vorstellen lässt, dass „gpt2-chatbot“ durch Selbstverbesserung trainiert wurde, haben wir viele Gründe zu glauben, dass es die erste erfolgreiche Umsetzung dessen ist, woran OpenAI seit Jahren arbeitet: die Langzeitinferenz.

Das Zeitalter der Langzeitinferenzmodelle

Im Laufe der Jahre haben mehrere Forschungsarbeiten von OpenAI auf diese Idee angespielt, Modelle in Richtung ’schwere Inferenz‘ zu verschieben.

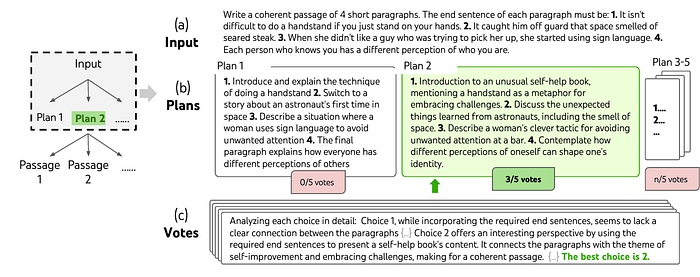

Beispielsweise präsentierten sie 2021 die Idee, ‚Verifier‘ bei der Inferenz zu verwenden, um die Antworten des Modells bei der Arbeit mit Mathematik zu verbessern.

Die Idee bestand darin, ein Hilfsmodell zu trainieren, das mehrere Antworten, die das Modell in Echtzeit gab, bewertet und die beste auswählt (die dann dem Benutzer bereitgestellt wird).

Dies, kombiniert mit einer Art von Suchalgorithmus wie dem, der von AlphaGo verwendet wird, mit Beispielen wie der Tree-of-Thought-Forschung von Google Deepmind für LLMs, und Sie könnten schließlich ein LLM erstellen, das, bevor es antwortet, den ‚Bereich möglicher Antworten‘ erkundet und sorgfältig den besten Weg zur Lösung auswählt.

Ein Beispiel für Tree-of-ThoughtDiese Idee, obwohl sie von OpenAI bereits 2021 vorgestellt wurde, ist in letzter Zeit sehr beliebt geworden, mit gemeinsamer Forschungsarbeit von Microsoft und Google zur Anwendung auf die Ausbildung von Verifizierern der nächsten Generation, und mit Google, das sogar ein Modell, Alphacode, geschaffen hat, das diese Art von Architektur mit großem Erfolg ausführt, wobei es die 85%-Perzentile unter den wettbewerbsfähigen Programmierern, den besten Menschen darin, erreicht.

Aber warum haben diese Modelle der nächsten Generation so viel Potenzial?

Nun, weil sie die Problemlösung auf eine sehr ähnliche Weise angehen wie Menschen, durch die Ausübung von absichtlichem und ausgedehntem Denken, um eine bestimmte Aufgabe zu lösen.

Das Fazit ist, dass Sie ‚Such- + LLM‘-Modelle als KI-Systeme betrachten können, die einen viel höheren Grad an Berechnung (ähnlich dem menschlichen Denken) für die tatsächliche Laufzeit des Modells zuweisen, so dass sie, anstatt die richtige Lösung sofort erraten zu müssen, einfach ‚mehr Zeit zum Nachdenken‘ haben.

Aber OpenAI ist noch weiter gegangen.

PRM-Modelle für eine verbesserte Mathematikausführung

Im letzten Mai veröffentlichten sie das Papier Let’s Verify Step-by-Step mit der Beteiligung von Ilya Sutskever, Chief Scientist bei OpenAI, und einigen der Forscher aus dem ursprünglichen Verifier-Papier wie Karl Cobbe.

Die Idee hier ist, das Belohnungsmodell zu modifizieren, das während der Ausrichtungsphase des Modells verwendet wird.

Ich empfehle, diesen Artikel für eine vollständige Anleitung zum LLM-Training zu überprüfen, aber der letzte Schritt im Prozess der Erstellung von Produkten wie ChatGPT ist die Verwendung von Verstärkungslernen aus menschlichem Feedback, oder RLHF.

Die Idee ist, dass das Modell seine Entscheidungsfindung verbessert. Daher trainieren wir ein Hilfsbelohnungsmodell (das im Wesentlichen eine fast identische Kopie des trainierten Modells ist), das lernt, die Ergebnisse des trainierten Modells gemäß den menschlichen Präferenzen zu bewerten.

Das Problem?

Nun, die meisten Belohnungsmodelle heute sind ORMs, oder Outcome-Supervised Reward Models. In einfachen Worten, um den Grad der Richtigkeit der Vorhersage des Modells zu bewerten, betrachten sie sie global, wobei sie den gesamten ‚Denkprozess‘ außer Acht lassen.

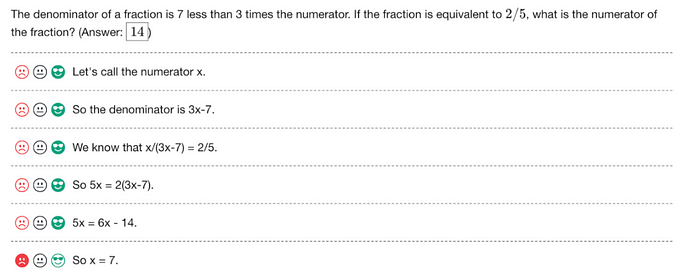

Auf der anderen Seite bewerten PRMs, oder Prozess-Supervised Reward Models, jeden einzelnen Schritt in der Antwort des Modells. Folglich ‚zwingen‘ sie das Modell, jedem einzelnen Schritt des Prozesses Aufmerksamkeit und Mühe zu schenken, was in Situationen wie der Lösung einer Mathematikaufgabe wie der unten stehenden von entscheidender Bedeutung ist:

Allerdings ist dies ein sehr, sehr teurer Prozess, da die Präferenzdaten eine schwere manuelle Erstellung erfordern, damit das überwachende Signal angewendet werden kann. Folglich hat jedes einzelne Trainingsbeispiel Dutzende oder mehr Belohnungen, um zu messen.

Daher könnte „gpt2-chatbot“ möglicherweise eine Art von Variation der Belohnungsschulung enthalten, wenn man bedenkt, wie geschickt es darin ist, Pläne zu erstellen und komplexe Problemlösungen auszuführen.

Unmöglich, nicht aufgeregt zu sein

Angesichts der unglaublichen Leistung von gpt2-chatbot und unter Berücksichtigung der jüngsten Forschung von OpenAI und der Lecks, haben wir wahrscheinlich eine ziemlich gute Vorstellung davon, was zum Teufel dieses Ding ist.

Was wir mit Sicherheit wissen, ist, dass wir bald mit einem völlig anderen Tier konfrontiert sein werden, einem, das den Einfluss der KI auf die nächste Ebene heben wird.

- Haben wir endlich den Meilenstein erreicht, dass LLMs die menschliche Leistung übertreffen können, wie wir es mit AlphaGo getan haben?

- Ist das Zeitalter der Langzeitinferenz, d.h. die Eroberung des System-2-Denkens durch die KI, angebrochen?

Wahrscheinlich nicht. Aber es ist schwer, nicht hochgradig optimistisch zu sein für die unglaublichen Entwicklungen, die wir in den kommenden Monaten beobachten werden.