Endlich hat OpenAI GPT-4o präsentiert! Dieses neue Modell bietet Echtzeit-Multimodalitätsfunktionen in Audio, Vision und Text, aber jetzt mit erheblichen Verbesserungen. Es ist kostenlos zu benutzen, was einer Strategie ähnelt, die bei GPT 3.5 angewandt wurde – mit dem Ziel, neue Nutzer anzuziehen und das Modelltraining weiter zu skalieren.

Laut Mia Murati ist eine bemerkenswerte Eigenschaft des GPT-4o-Modells seine Leistung, die bis zu doppelt so schnell ist wie die seines Vorgängers, GPT-4. Außerdem wurden die Kosten um bis zu 50% gesenkt. Diese Entwicklung wird es Entwicklern ermöglichen, weiterhin groß angelegte AI-Projekte umzusetzen und gleichzeitig von diesen neuen Verbesserungen zu profitieren.

Aber genug von den technischen Details. Lassen Sie uns sehen, was dieses neue Modell für uns tun kann!

Echtzeit-Vision

Dies geht über die grundlegende Funktionalität des Hochladens eines Bildes und der Interaktion mit ihm hinaus. OpenAI ermöglicht es uns jetzt, mit ChatGPT über den Sprachassistenten zu interagieren und sogar Inhalte von unseren Computern oder Smartphones zu teilen. Die Antworten werden in Echtzeit generiert, was eine Vielzahl von Analysen über verschiedene Typen und Komplexitätsstufen hinweg ermöglicht.

In der Demo unten wird ChatGPT zu einem Mathe-Tutor (es hat meinen Verstand gesprengt!).

Hier sehen wir einen Bruchteil der vollen Fähigkeiten von ChatGPT. Es löst nicht nur ein Math-Problem, sondern führt uns auch Schritt für Schritt zur Lösung, indem es klare Richtlinien und Empfehlungen gibt, die uns helfen, den gesamten Prozess auf eine lehrreichere und anschaulichere Weise zu verstehen.

Es ist erstaunlich, wie die Sprach- und Vision-Fähigkeiten reibungslos Fragen erkennen und interpretieren.

Echtzeit-gesprochene Konversation

OpenAI hat sich sorgfältig auf Fähigkeiten wie Flüssigkeit, Ton und logische Abfolge konzentriert, was es dem Modell ermöglicht, Gespräche auf natürliche Weise fortzusetzen.

Während der Präsentation von GPT-4o konnte das Modell flüssige Gespräche führen und sogar Empfehlungen in einem freundlichen Ton geben, wie ein echter Assistent es tun würde. Das Modell ist in der Lage, Stimmen in einer Reihe von emotionalen Stilen zu produzieren, wobei die Wahl zwischen dramatischeren und ernsteren, formelleren Tönen getroffen werden kann.

Hier ist eine Demo, die die Fähigkeiten zur Echtzeit-Konversation mit der Audio-Übersetzung kombiniert.

Der Prozess, ChatGPT mit Prompts zu versorgen, ist etwas komplexer, als es scheint. Es muss eine zweisprachige Konversation in Englisch und Spanisch reibungslos interpretieren, beide Sprachen erkennen und entsprechende Antworten generieren.

Ich bin beeindruckt von seiner Genauigkeit und Flüssigkeit bei der Antwort, da es mühelos die gesteckten Ziele erreicht. Es schafft es auch, die unangenehmen Pausen zu vermeiden, die bei anderen AI-Systemen, die Echtzeit-Antworten geben, häufig zu sehen sind.

Sind die Demos so „gefälscht“ wie die von Google?

In mehreren Demos versucht OpenAI zu zeigen, dass die Videos nicht nur eine geschickte Bearbeitung sind, sondern tatsächlich in Echtzeit stattfinden. Ein gutes Beispiel ist das Video unten, in dem gezeigt wird, wie die Multimodalitätsfunktionen zusammenarbeiten, um präzise Antworten auf der Grundlage dessen zu geben, was gesehen und gehört werden kann.

Hier sind einige Punkte, die ich hervorheben möchte:

- Es ist bemerkenswert, wie genau ChatGPT detaillierte Elemente erkennt und beschreibt. Selbst als die Umgebung komplexer wurde und Menschen hinzukamen, erkannte ChatGPT sie erfolgreich.

- Es ist erstaunlich, dass dieses neue Modell ein Lied schaffen kann, das bestimmten Bedingungen entspricht. Es hat mühelos Melodien generiert!

- Die Interaktion zwischen den beiden GPT-Modellen schien fast wie ein Blick in die Zukunft. Während es nicht ausdrücklich gesagt wurde, scheint dies die Richtung zu sein, in die OpenAI geht. Mit den von GPT-4o gezeigten Fähigkeiten ist der nächste Schritt, dass AI-Systeme miteinander interagieren. Dies könnte zu einer Situation führen, in der ein AI-System ein anderes trainiert und zu anderen Entwicklungen, die wir uns nicht einmal in unseren kühnsten Träumen vorstellen können.

GPT-4o hat andere AI-Modelle übertroffen

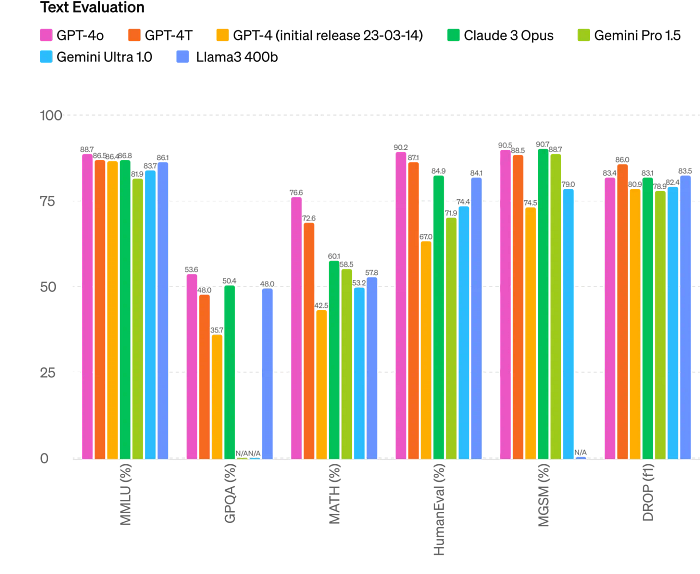

Text-Bewertung

Das von OpenAI geteilte Bild zeigt deutlich, dass GPT-4o andere Modelle übertrifft, insbesondere in Bereichen wie Mathematik und HumanEval – Eigenschaften, die von Nutzern hoch geschätzt werden, da sie flüssigere und menschlichere Konversationen ermöglichen.

Darüber hinaus hat GPT-4o seine Antwortfähigkeiten über Englisch hinaus auf über 20 weitere Sprachen erweitert. Diese Verbesserung der Sprachtokenisierung soll eine breitere globale Zielgruppe erreichen.

Text-Bewertung – https://openai.com/index/hello-gpt-4o/

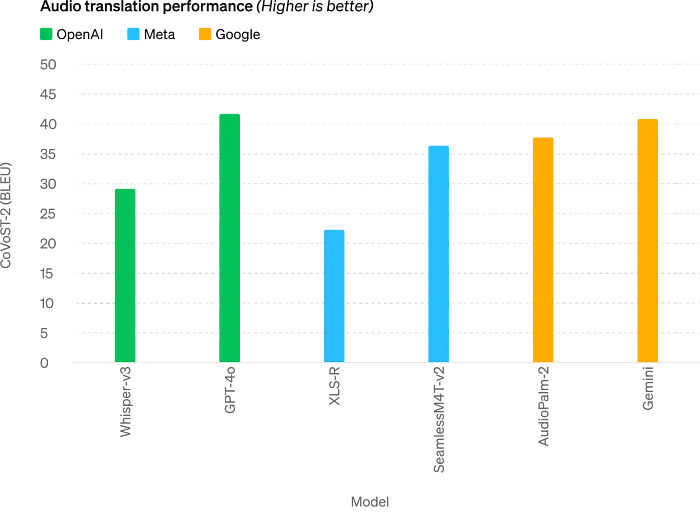

Leistung der Audio-Übersetzung

Die verbesserten Fähigkeiten von GPT-4o, gepaart mit seiner Text-Bewertungsfunktion, bieten die Möglichkeit, sich mit mehr Menschen zu verbinden, wobei anerkannt wird, dass Sprache oft eine Barriere darstellt, die über die bloße Kommunikation hinausgeht.

Die Grafik zeigt deutlich, dass GPT-4o andere AI-Systeme wie Gemini und Whisper-v3 übertroffen hat.

Mehr als ein kleines Update

Für mich geht es hier um mehr als nur ein neues Update für ChatGPT. Es ist viel bedeutsamer, wenn es darum geht, AI mit der Umgebung zu verbinden und ihr Potenzial zu maximieren. Außerdem ist dies genau das, was ich von OpenAI erwartet habe: ein Produkt zu liefern, das sich auf den Nutzer konzentriert, und zwar durch greifbare und authentische Maßnahmen von Anfang an. Die Rolle der Multimodalität ist hier entscheidend, und sie waren sich dessen bewusst, daher ihre Bemühungen, sie zu verbessern, um in verschiedenen realen Kontexten präzisere Antworten zu geben.

Jetzt haben wir ein Produkt, das sich weniger „künstlich“ anfühlt und einige unserer Anforderungen erfüllt. GPT-4o ist einer der ersten Schritte hin zu dem, was GPT-5 sein wird, und zeigt die Initiative von OpenAI, die Nutzer zu ermutigen, diese KI in neuen Kontexten einzusetzen.