Die Bereitstellung von Open-Source-Modellen kann eine herausfordernde Aufgabe sein, insbesondere wenn man Faktoren wie Datenschutz, Sicherheit und Kosteneffizienz berücksichtigt. Mit dem richtigen Wissen und den richtigen Plattformen kann dieser Prozess jedoch erheblich vereinfacht werden. Ich habe umfangreiche Recherchen zu Preisen, Geschwindigkeit und anderen Faktoren wie Datenschutz und Kontrolle durchgeführt und die beste mögliche Methode zur Bereitstellung eines Open-Source-LLM-Modells (im Mai 2024) gefunden.

Ich unterteile die gesamten Bereitstellungen in 2 Kategorien: Selbstverwaltet und gehostete APIs

Selbstverwaltete Bereitstellung für LLMs

Die Bereitstellung von Large Language Models (LLMs) in einer selbstverwalteten Umgebung kann eine herausfordernde, aber lohnende Aufgabe sein. Diese Vorgehensweise bietet die volle Kontrolle über das Modell, was eine größere Flexibilität zur Modifizierung, zum Training oder zur Feinabstimmung des Modells ermöglicht. Die Herausforderungen umfassen eine hohe Latenzzeit und einen zusätzlichen Preis sowie ein technisches Verständnis von MLOps für eine erfolgreiche Bereitstellung.

Wie funktioniert diese Methode?

Diese Methode umfasst in der Regel das Mieten einer eigenen GPU-Instanz (wie einem großen EC2 oder Azure VM) und anschließend die manuelle Bereitstellung, bei der zunächst Python installiert werden muss, dann ein LLM-Image von Hugging Face geladen wird, dann alle Abhängigkeiten installiert werden und schließlich die Firewall oder die Nginx-Routen konfiguriert werden, um einen bereitgestellten Link zu erhalten.

Vorteile und Nachteile dieser Methode:

Vorteile:

- Volle Kontrolle: Die selbstverwaltete Bereitstellung bietet die volle Kontrolle über das Modell, was eine größere Flexibilität zur Modifizierung, zum Training oder zur Feinabstimmung des Modells ermöglicht.

- Benutzererfahrung: Das Verständnis der Stärken und Grenzen von LLMs und die effektive Nutzung ihrer Fähigkeiten kann zur Entwicklung innovativer und wirkungsvoller Anwendungen in verschiedenen Bereichen führen.

Nachteile:

- Kosten und Latenzzeit: Längere Eingaben erhöhen die Kosten der Inferenz, während die Länge der Ausgabe direkt die Latenzzeit beeinflusst. Es ist jedoch wichtig anzumerken, dass die Kosten- und Latenzanalyse für LLMs aufgrund der raschen Entwicklung des Bereichs schnell veraltet sein kann.

- Ressourcenintensiv: Die selbstverwaltete Bereitstellung von LLMs kann ressourcenintensiv sein, was erhebliche Rechenleistung und Speicherkapazität erfordert. Dies kann für alle Organisationen nicht praktikabel sein, insbesondere für kleinere Unternehmen mit begrenzten Ressourcen.

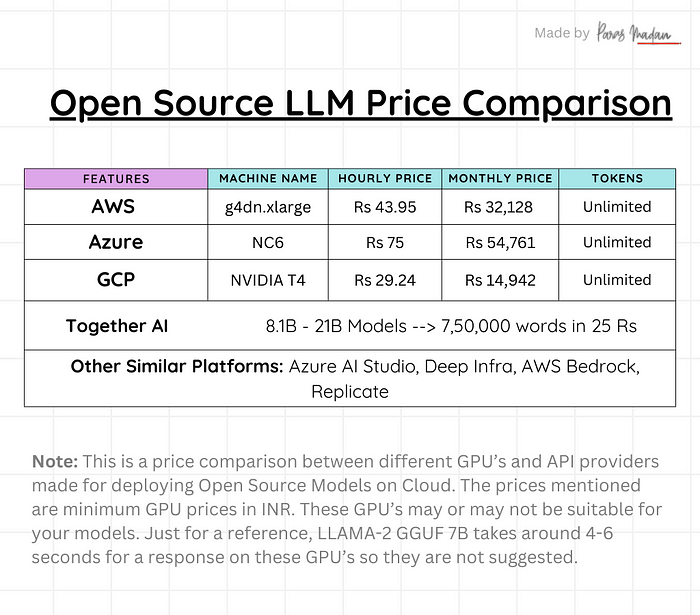

Preisvergleich zwischen selbstverwalteten LLMs und gehosteten LLM-APIs

Gehostete Open-Source-LLM-APIs

Diese Methode beinhaltet die Verwendung von Plattformen wie Together AI, Replicate usw., die APIs für all diese Open-Source-Modelle zu einem sehr effektiven Preis anbieten. Sie müssen lediglich deren Codeblock verwenden und die Namen der verschiedenen Modelle ändern, die Sie verwenden möchten, und das war’s. Egal, ob morgen oder übermorgen ein neues Modell veröffentlicht wird, Ihr Codeblock bleibt immer gleich. Hier sind einige gehostete Open-Source-LLM-APIs:

1. Together AI

2. Replicate

3. Deep Infra

4. Perplexity

5. AWS Bedrock

Vorteile und Nachteile von gehosteten Open-Source-LLM-APIs

Vorteile:

- Einfache Bedienung: Gehostete APIs bieten eine Plattform für Entwickler, um die Leistungsfähigkeit von LLMs zu nutzen, ohne die zugrunde liegende Infrastruktur verwalten zu müssen. Dies ermöglicht es den Entwicklern, sich auf den Aufbau von Anwendungen und Diensten zu konzentrieren, die die Fähigkeiten von LLMs nutzen.

- Flexibilität: Diese APIs unterstützen in der Regel eine Vielzahl von Programmiersprachen und Plattformen, was sie für verschiedene Entwicklungsumgebungen vielseitig macht.

- Kosteneffizient: Die Verwendung von gehosteten APIs kann kosteneffizienter sein als der Aufbau und die Wartung einer eigenen Infrastruktur für die Bereitstellung von LLMs.

Nachteile:

- Eingeschränkte Kontrolle: Während gehostete APIs eine einfache Bedienung bieten, bieten sie möglicherweise nicht die gleiche Kontrolle über das Modell wie selbstverwaltete Bereitstellungen. Dies könnte die Fähigkeit einschränken, das Modell zu modifizieren, zu trainieren oder feinabzustimmen.

- Abhängigkeit: Es besteht eine Abhängigkeit vom Anbieter des Dienstes für die Verfügbarkeit und die Leistung der API. Jede Ausfallzeit oder Leistungsprobleme beim Anbieter des Dienstes können sich direkt auf die Anwendungen und Dienste auswirken, die die API nutzen.

Was ist für Sie am besten?

Abhängig von Ihrem Anwendungsfall und den Gesamtkosten können Sie zu einem endgültigen Schluss kommen. Wenn Sie mich jedoch fragen, wäre mein persönlicher Rat folgender:

Gehostete Open-Source-LLM-APIs für:

— Persönliche Projekte

— Unternehmensprojekte, bei denen Sicherheit und Datenschutz keine große Rolle spielen

— Kundenorientierte Anwendungen, bei denen Geschwindigkeit wichtig ist und das für das Projekt zugewiesene Budget gering ist

— Start-ups, die Eigenkapital einsetzen