Was machen wir heute?

Konzentriere dich mehr auf das Wie wir bauen, als auf das Was wir bauen

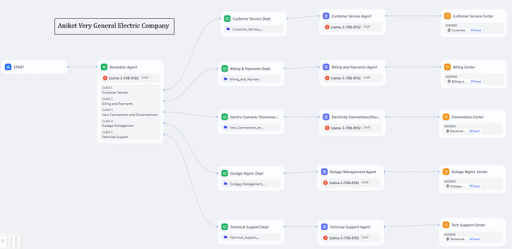

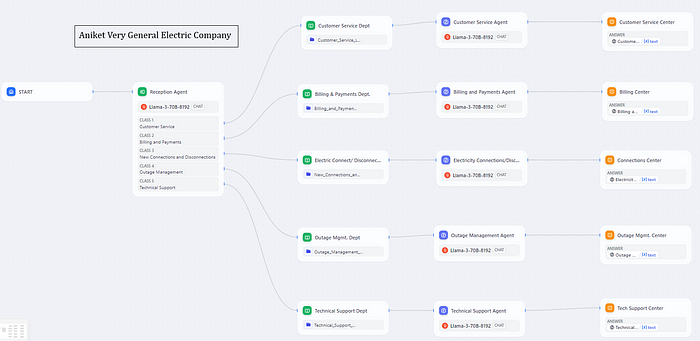

Heute werden wir ein Business Process Outsourcing (BPO) Callcenter für ein fiktives Unternehmen namens „Aniket Very General Electric Company“ erstellen. Dieses Callcenter wird jedoch nicht das typische Callcenter mit menschlichen Mitarbeitern sein. Stattdessen werden wir verschiedene Abteilungen mit KI-Agenten als Mitarbeitern erstellen.

Die Abteilungen, die wir einrichten werden, umfassen den Kundenservice, die Rechnungsstellung & Zahlungen, den technischen Support, das Ausfallmanagement und die neuen Verbindungen oder Trennungen. Die Idee ist, dass Kunden dieses Unternehmens mit diesen KI-Agenten chatten (und in Zukunft sprechen) können, um Fragen zu stellen, Beschwerden einzureichen oder Dienstleistungen anzufordern.

Wenn ein Kunde ein Gespräch beginnt, begrüßt ein Empfangs-KI-Agent ihn und leitet seine Anfrage an die entsprechende Abteilung weiter. Wenn es beispielsweise ein Rechnungsproblem ist, wird der Empfangsagent den Kunden an einen KI-Agenten in der Abteilung Rechnungsstellung & Zahlungen weiterleiten, der ihm dann bei seinem spezifischen Anliegen hilft.

Ähnlich verhält es sich, wenn ein Kunde technischen Support benötigt. Er wird dann mit einem KI-Agenten aus dem Technik-Team verbunden, der ihm Anleitungen zur Fehlerbehebung, Energiespartipps oder andere technische Informationen zu seinem Stromservice geben kann.

Die Schönheit dieses Systems ist, dass es vollständig automatisiert ist, mit KI-Agenten, die rund um die Uhr verfügbar sind, um Kundenanfragen zu bearbeiten, ohne dass menschliches Eingreifen erforderlich ist. Während wir Fortschritte machen, werden wir sogar Sprachfähigkeiten aktivieren, so dass Kunden mit diesen KI-Agenten sprechen können, die mit natürlich klingender Stimme antworten (in einem zukünftigen Artikel).

Stell dir das potenzielle Effizienzsteigerungen und Kosteneinsparungen vor, die durch einen KI-Arbeitskräfte möglich sind, die rund um die Uhr arbeiten können und die Stärken der menschlichen Mitarbeiter ergänzen. Das ist die Kraft, die wir in unserem eigenen BPO-Unternehmen heute nutzen wollen.

Warum solltest du diesen Artikel lesen?

Du solltest diesen Artikel lesen, weil es darin um etwas geht, das in Zukunft groß sein wird – die Verwendung von KI-Agenten in Branchen wie dem Kundenservice und dem Business Process Outsourcing (BPO). Das Erlernen der Fähigkeit, KI-Agenten zu erstellen, die Aufgaben wie die Beantwortung von Kundenanfragen, die Bereitstellung von technischem Support und die Verwaltung von Geschäftsprozessen übernehmen können, ist eine Fähigkeit, die in naher Zukunft sehr gefragt sein wird.

KI wird immer schlauer und schneller. Bald werden KI-Agenten in der Lage sein, viele dieser Jobs besser, schneller und billiger zu erledigen. Unternehmen, die lernen, wie man KI-Agenten einsetzt, werden einen großen Vorsprung vor ihren Mitbewerbern haben. Das Lesen dieses Artikels wird dir einige der grundlegenden Fähigkeiten beibringen, die du brauchst, um deine eigene KI-Mitarbeiterbeschaffung aufzubauen. Das ist eine Fähigkeit, die ganze Branchen durcheinanderbringen und viele neue Möglichkeiten schaffen kann.

Wie werden wir unser Unternehmen mit komplett KI-Mitarbeitern aufbauen?

Was wir bauen, kann für jede Branche eingesetzt werden.

Was ist BPO und wie funktionieren Callcenter?

Business Process Outsourcing (BPO) ist die Beauftragung eines externen Dienstleisters mit der Durchführung bestimmter Geschäftsprozesse oder -operationen. Ein häufiges Beispiel sind Callcenter, bei denen Unternehmen ihren Kundenservice an ein BPO-Unternehmen auslagern, das Agenten hat, die Anrufe entgegennehmen, Beschwerden bearbeiten und Support im Namen des Kundenunternehmens leisten.

Unsere Abteilungen

In unserem KI-gestützten BPO-Unternehmen werden wir mehrere Schlüsselabteilungen mit KI-Agenten besetzen.

- Kundenservice

- Technischer Support

- Rechnungsstellung & Zahlungen

- Ausfallmanagement

- Onboarding von Kunden

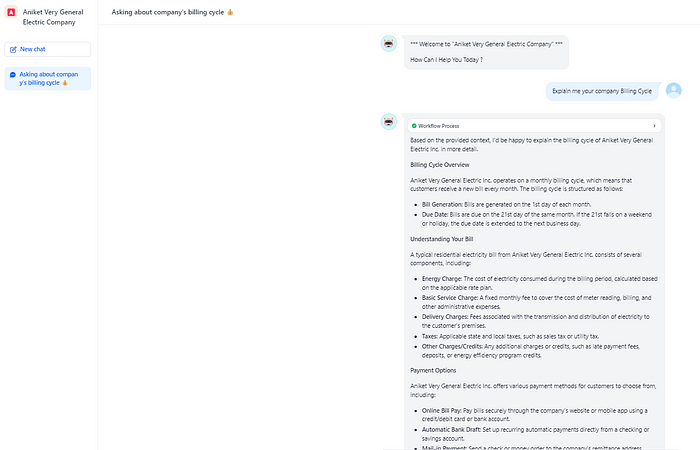

Die Abteilung Kundenservice wird allgemeine Anfragen und Beschwerden von Kunden zu ihrem Stromservice bearbeiten. Das Technik-Team wird bei technischen Problemen, Fehlerbehebung und Energiespartipps helfen. Die Abteilung Rechnungsstellung & Zahlungen wird sich um Rechnungsanfragen, Zahlungsoptionen und die Verwaltung von Konten kümmern. Das Ausfallmanagement-Team wird Ausfälle verfolgen und Aktualisierungen zu den Einsätzen der Mannschaften und den Wiederherstellungsbemühungen geben. Schließlich wird die Onboarding-Abteilung neue Kundenanmeldungen, Serviceverbindungen und die Kontoeinrichtung übernehmen.

Lass uns das Design entwerfen

Docker zur Ausführung von Dify KI

Wir werden Docker-Container verwenden, um die Dify KI-Plattform (https://github.com/langgenius/dify) auszuführen, die als Grundlage für unsere KI-Agenten dienen wird. Docker bietet eine konsistente und isolierte Umgebung für die Bereitstellung und Skalierung unserer KI-Anwendungen.

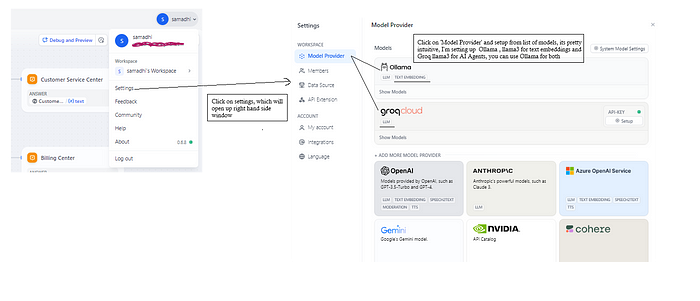

Ollama mit LLaMA-3 als KI-Agent

Der Kern unserer KI-Agenten wird das Ollama-Sprachmodell sein, angetrieben von dem State-of-the-Art LLaMA-3 . LLaMA-3 ist ein allgemeines großes Sprachmodell, das von Meta AI entwickelt wurde und für eine Vielzahl von Aufgaben der natürlichen Sprachverarbeitung eingesetzt werden kann, einschließlich konversationsfähiger KI.

Groq (optional) API für schnellere LLaMA-3

Für eine optimale Leistung können wir die Groq KI-Beschleuniger-Chip-API integrieren, die die Inferenzgeschwindigkeit von LLaMA-3 erheblich erhöhen kann, so dass unsere KI-Agenten schneller auf Kundenanfragen reagieren können.

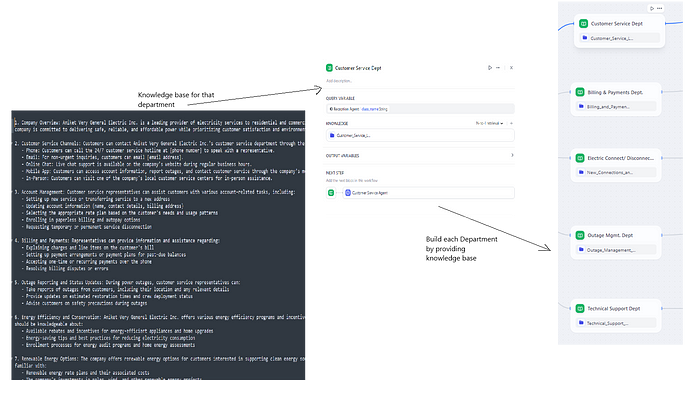

Wissensdatenbank / Datenbank

Jeder KI-Agent wird Zugang zu einer umfassenden Wissensdatenbank haben, die in Textdateien gespeichert ist. Diese Dateien werden detaillierte Informationen, Verfahren und bewährte Verfahren enthalten, die für den Betrieb der jeweiligen Abteilung spezifisch sind, wie z.B. Rechnungsrichtlinien, technische Fehlerbehebungsanleitungen und Ausfallmanagement-Protokolle. Die KI-Agenten werden sich auf diese Wissensdatenbank beziehen, um den Kunden genaue und relevante Antworten zu geben.

Durch die Kombination fortschrittlicher Sprachmodelle wie LLaMA-3 mit domänenspezifischen Wissensdatenbanken und optionalen Leistungsoptimierungen wie Groq wollen wir eine hochfähige, reaktionsschnelle und skalierbare KI-gestützte Belegschaft für unser BPO-Unternehmen schaffen.

Lass uns loslegen!

Einrichtung

Docker

Docker auf Windows einrichten

--------------------------------

* Besuche die Docker Desktop-Website (https://www.docker.com/products/docker-desktop) und lade den Installer für Windows herunter.

* Führe den Installer aus und folge den Anweisungen auf dem Bildschirm, um den Installationsvorgang abzuschließen.

* Öffne nach der Installation die Docker Desktop-Anwendung und warte, bis sie gestartet ist.

* Wenn du dazu aufgefordert wirst, melde dich an oder erstelle ein Docker-Konto.

* Nach Abschluss der Installation kannst du überprüfen, ob Docker ausgeführt wird, indem du in einer Eingabeaufforderung oder PowerShell "docker --version" eingibst.

Docker auf Mac einrichten

--------------------------------

* Besuche die Docker Desktop-Website (https://www.docker.com/products/docker-desktop) und lade den Installer für Mac herunter.

* Doppelklicke auf die heruntergeladene .dmg-Datei, um den Installer zu mounten.

* Ziehe das Docker-Symbol in den Anwendungsordner, um Docker Desktop zu installieren.

* Öffne nach der Installation die Docker Desktop-Anwendung aus dem Anwendungsordner.

* Wenn du dazu aufgefordert wirst, melde dich an oder erstelle ein Docker-Konto.

* Nach Abschluss der Installation kannst du überprüfen, ob Docker ausgeführt wird, indem du in einem Terminal "docker --version" eingibst.

Ollama

* Besuche https://ollama.com/download in deinem Webbrowser

* Klicke auf die Schaltfläche "Windows" oder "macOS", um den Ollama-Installer für Windows herunterzuladen

* Sobald der Download abgeschlossen ist, führe die ausführbare Installationsdatei aus

* Folge den Anweisungen auf dem Bildschirm, um den Installationsvorgang abzuschließen

* Nach der Installation kannst du Ollama über das Startmenü starten

Nach dem Starten von Ollama kannst du verschiedene große Sprachmodelle wie LLaMA-3, Mistral, etc. herunterladen und ausführen

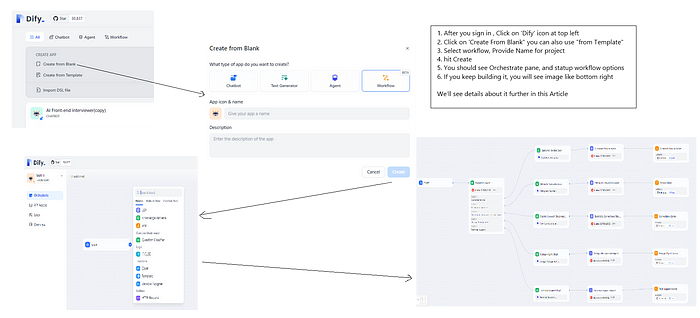

Dify KI

* Erstellle und navigiere zu deinem Projekt-Stammverzeichnis

* Klone mit git https://github.com/langgenius/dify.git

* Navigiere zu dify/docker

* Stelle sicher, dass dein Docker ausgeführt wird, gib "docker compose up -d" ein

* Überprüfe, ob alle Dienste ausgeführt werden und navigieren zu http://localhost/signin und richte ein Konto ein (es ist nur lokal)

KI-Agenten zur Dify-Plattform hinzufügen

Lass uns unsere Organisation entwerfen

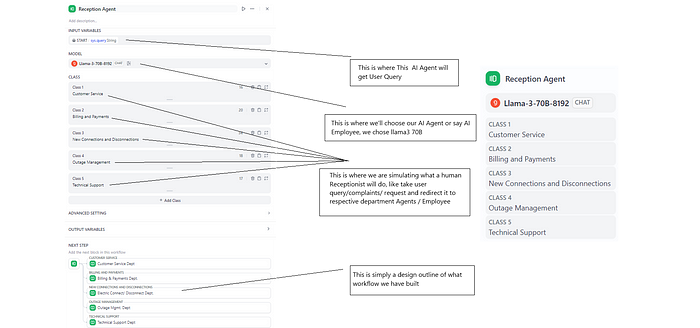

Empfangs-Agent:

- Begrüßt Besucher und bearbeitet Anfragen am Empfang.

- Leitet Anrufe und Nachrichten an die entsprechenden Abteilungen weiter. (Wir werden bald Sprachausgabe hinzufügen)

- Stellt grundlegende Informationen über das Unternehmen bereit.

Kundenservice-Agent:

- Unterstützt Kunden bei verschiedenen Anfragen, Bedenken und Auskünften.

- Stellt Informationen über Produkte, Dienstleistungen und Richtlinien bereit.

- Sorgt für die allgemeine Kundenzufriedenheit.

Rechnungs- und Zahlungs-Agent:

- Verwaltet Rechnungsanfragen, Zahlungsabwicklung und kontobezogene Probleme.

- Hilft Kunden, Rechnungen, Fälligkeitsdaten und Zahlungsmethoden zu verstehen.

Agent für Stromverbindungen und -trennungen:

- Bearbeitet Anfragen im Zusammenhang mit Stromverbindungen und -trennungen.

- Koordiniert sich mit Stromversorgern und Kunden, um einen reibungslosen Übergang zu gewährleisten.

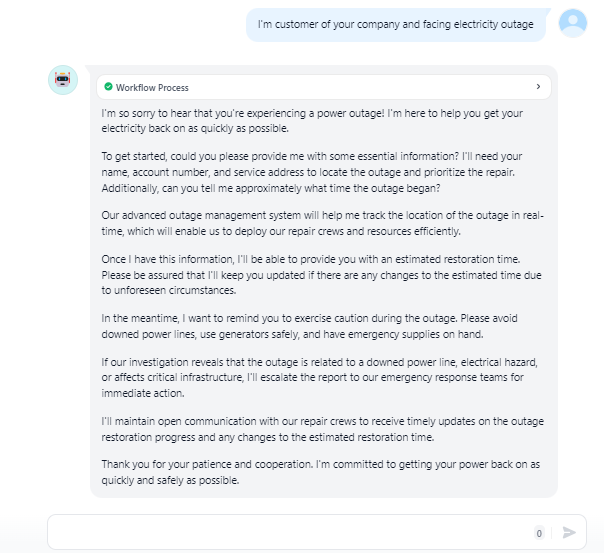

Ausfallmanagement-Agent:

- Reagiert auf Stromausfälle, Störungen und Notfälle.

- Koordiniert die Wiederherstellungsbemühungen und kommuniziert Aktualisierungen an die betroffenen Kunden.

Technischer Support-Agent:

- Unterstützt Kunden bei technischen Problemen im Zusammenhang mit Produkten oder Dienstleistungen.

- Behebt Software-, Hardware- oder Netzwerkprobleme.

- Stellt Lösungen bereit, um einen unterbrechungsfreien Service zu gewährleisten.

Diese Agenten tragen gemeinsam zu einem effizienten Betrieb des KI-gestützten BPO-Unternehmens bei und sorgen für eine hervorragende Kundeninteraktion und eine straffe Abwicklung. Wenn du weitere Fragen hast oder weitere Einzelheiten benötigst, zögere nicht, mich zu fragen!

Empfangs-Agent

Lass uns die Abteilungen aufbauen

- Denke daran, dass jede Abteilung in einem Unternehmen über eine Art interne Wissensdatenbank oder Datenbank verfügt.

- Die Mitarbeiter beziehen sich von Zeit zu Zeit auf diese Wissensdatenbank, wenn sie Richtlinien, Schritte, Verfahren und andere Informationen nachschlagen müssen, um den Kunden gut zu bedienen.

- Wir machen hier das Gleiche. Das obige Diagramm zeigt, wie wir verschiedene Abteilungen wie Kundenservice, Technischer Support, Rechnungswesen usw. eingerichtet haben. Und für jede Abteilung haben wir eine gemeinsame Wissensdatenbank erstellt.

- Diese Wissensdatenbank ist wie eine große Sammlung von Informationen, auf die die KI-Agenten in dieser Abteilung zugreifen können. Sie enthält alle wichtigen Details, die sie möglicherweise benötigen – Richtlinien, Fehlerbehebungsanleitungen, Rechnungsregeln usw.

- Wenn also ein Kunde dem KI-Agenten eine Frage stellt, kann der Agent schnell in der Wissensdatenbank der Abteilung nachschauen, um die richtigen Informationen zu finden, um sie genau zu beantworten.

- Es ist so, als hätte man ein Mitarbeiterhandbuch oder eine Schulungsanleitung, aber für die KI-Agenten statt der menschlichen Mitarbeiter. Die Wissensdatenbank bringt den KI bei, was sie wissen müssen, um ihren Job gut zu machen.

- Und im Gegensatz zu menschlichen Mitarbeitern, die möglicherweise im Laufe der Zeit Dinge vergessen, haben die KI-Agenten immer vollen Zugriff auf diese gesamte Wissensdatenbank. Sie können sich so oft wie nötig darauf beziehen.

- Indem wir jeder Abteilung ihre eigene maßgeschneiderte Wissensdatenbank zur Verfügung stellen, stellen wir sicher, dass die KI-Agenten alle spezifischen Informationen und Fachkenntnisse haben, die sie für die Arbeit in diesem bestimmten Bereich benötigen.

- Egal, ob es sich um technischen Support, den Umgang mit Ausfällen, die Bearbeitung neuer Serviceverbindungen oder etwas anderes handelt, die KI kann die Wissensdatenbank konsultieren und auf ihren großen Datenpool zurückgreifen, um den Kunden gut zu bedienen.

Also, um es in einfachen Worten auszudrücken, haben wir unsere KI-Mitarbeiter mit detaillierten Abteilungs-Wissensdatenbanken ausgestattet, auf die sie jederzeit frei zugreifen können, um sicherzustellen, dass sie hilfreiche, genaue und wissende Antworten geben.

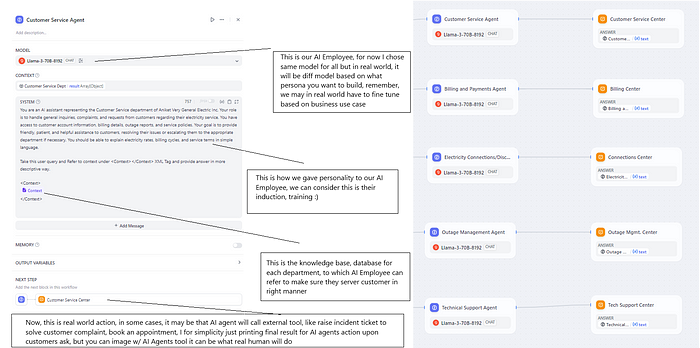

Lass uns unsere KI-Mitarbeiter kennenlernen

Für unser KI-gestütztes BPO-Unternehmen haben wir uns für das LLaMA-3 70B-Modell als Basis für alle unsere KI-Mitarbeiter in den verschiedenen Abteilungen entschieden. Das LLaMA-3 ist ein leistungsstarkes großes Sprachmodell, das gut für konversationsfähige KI-Agenten geeignet ist. In der realen Welt könnten jedoch möglicherweise Modelle mit unterschiedlichen Fähigkeiten eingesetzt werden, je nach den spezifischen Anforderungen und der Persönlichkeit der KI-Agenten jeder Abteilung. Außerdem wäre wahrscheinlich eine weitere Feinabstimmung dieser Modelle erforderlich, um ihre Leistung für die vorgesehenen Anwendungsfälle zu optimieren.

Bevor wir unsere KI-Mitarbeiter einsetzen, haben wir sie mit maßgeschneiderten Aufforderungen ausgestattet, um ihre Persönlichkeiten zu definieren, Erwartungen zu setzen und ihre Rollen und Aufgabenbereiche zu umreißen. Diese Aufforderungen wirken wie ein Arbeitsprofil und formen, wie die KI-Agenten mit Kunden interagieren und an ihre Aufgaben herangehen werden. Beispielsweise könnte der Kundenservice-KI eine freundliche und geduldige Persönlichkeit haben, während der Technische Support-KI eher analytisch und detailorientiert sein könnte.

Mit ihren Persönlichkeiten etabliert, haben wir unseren KI-Mitarbeitern umfassende Wissensdatenbanken zur Verfügung gestellt, die auf ihre jeweiligen Abteilungen zugeschnitten sind. Diese Wissensdatenbanken dienen als ihre Einführungsschulung und enthalten alle wesentlichen Informationen, Richtlinien, Verfahren und bewährten Verfahren, die sie benötigen, um Kunden effektiv zu unterstützen. Die KI-Agenten können sich bei Bedarf auf dieses Wissen beziehen, um sicherzustellen, dass ihre Antworten genau, aktuell und mit den Standards des Unternehmens übereinstimmen.

In unserer aktuellen Einrichtung haben wir die KI-Agenten mit einem einfachen Anzeigetool für die Interaktion mit Kunden ausgestattet. In der realen Welt hätten diese KI-Mitarbeiter jedoch wahrscheinlich Zugriff auf eine Suite von Tools und Integrationen, um ihre Fähigkeiten zu verbessern. Dazu könnte die Möglichkeit gehören, Vorfalltickets für Kundenbeschwerden zu erstellen, Termine oder Rückrufe zu vereinbaren, Serviceanfragen zu initiieren oder sogar mit externen Parteien oder Systemen zu interagieren, wenn dies erforderlich ist. Die Möglichkeiten sind vielfältig, und die richtige Kombination von Tools kann die Wirksamkeit der KI-Agenten bei der Kundenbetreuung und der Rationalisierung von Geschäftsprozessen erheblich steigern.

Lass uns unser BPO-Unternehmen in Betrieb nehmen

Mit unseren KI-Mitarbeitern und ihren Wissensdatenbanken an Ort und Stelle ist es an der Zeit, die Türen unseres BPO-Unternehmens zu öffnen. Dank der Kraft großer Sprachmodelle wie LLaMA-3 und der umfassenden Informationen, die wir zur Verfügung gestellt haben, sind unsere KI-Agenten gut gerüstet, um Kundenanfragen in verschiedenen Abteilungen zu bearbeiten. Egal, ob es sich um Rechnungsfragen handelt, technischen Support, das Management von Ausfällen oder die Onboarding von neuen Kunden – unsere KI-Mitarbeiter stehen bereit, um mit ihrem Fachwissen zu helfen.

Lass uns sehen, wie sie sich schlagen, wenn wir einige simulierte Szenarien aus der realen Welt durchspielen und unser vollständig automatisiertes BPO-Unternehmen in Aktion treten lassen.

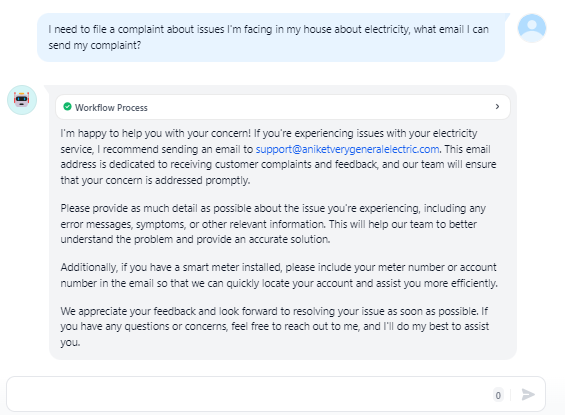

- Lass uns uns eine Vorstellung davon machen, wie „Aniket Very General Electric Company“ seine Kunden abrechnet. Rufen wir ihr Kundencenter an.

- Lass uns uns vorstellen, dass wir bereits Kunde dieses Unternehmens sind und einen Stromausfall haben. Lass uns sie um Hilfe bitten.

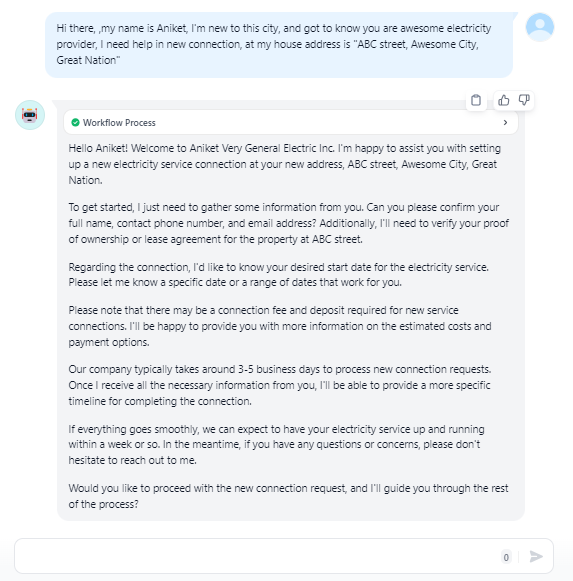

- Lass uns uns vorstellen, dass wir neu in der Stadt sind und einen Stromanschluss benötigen. Wir sind immer noch im Hotel, aber haben schon ein Haus gekauft und brauchen jetzt Strom. Lass uns sehen, ob das Kundencenter dieses Unternehmens uns helfen kann.

- Lass uns uns ein bisschen ärgern, nicht wahr? Lass uns sie fragen, ob sie uns ihre E-Mail-Adresse geben können, damit wir unsere Beschwerde mit allen Details einreichen können.

Stell dir vor, all dieser Text wird in Audio konvertiert (ich arbeite daran und werde es bald veröffentlichen) und wir haben ein voll funktionsfähiges (zumindest realitätsnahes) BPO-Unternehmen, egal zu welcher Tageszeit und an welchem Tag im Jahr.

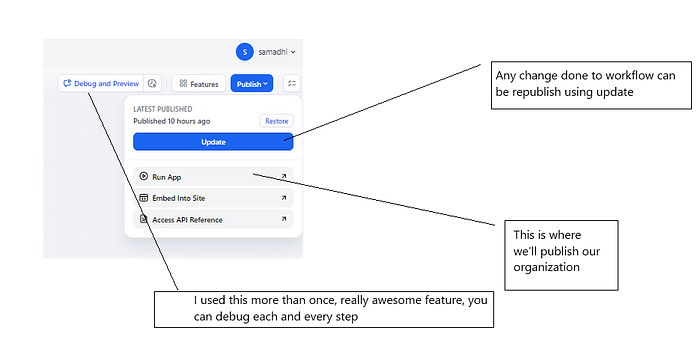

Debugging (wirklich toll!)

Diese Ergebnisse, die du oben gesehen hast, sind nicht einfach das, was ich verdrahtet, ausgeführt und gefragt habe. Es waren die Ergebnisse vieler fehlgeschlagener Versuche, dann meines Lernens, was ich falsch gemacht habe, und der Korrektur. Was diese Reise wirklich reibungslos gemacht hat, ist das Debugging (und die Entwickler da draußen, die dies lesen, wissen, dass das erste, was wir in jedem Framework sehen, ist, wie man debuggt 🙂 oder nicht?).

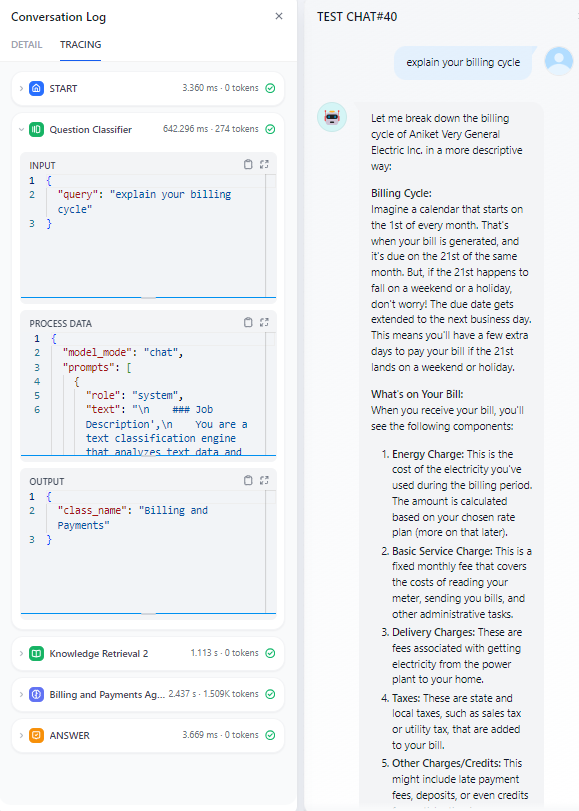

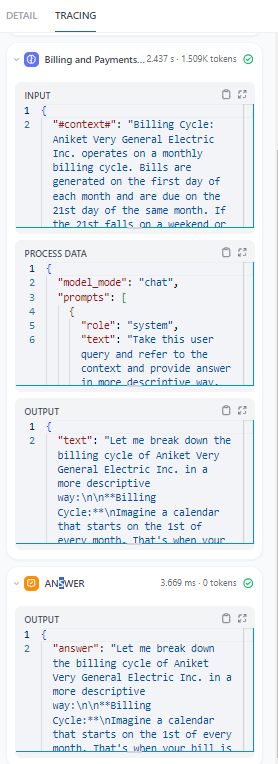

Hier sind einige Spuren aus meinen frühen Tests, die zeigen, wie unser Classifier LLM auf eine gegebene Abfrage reagiert, wie gut er die tiefe Bedeutung der Kundenabfrage erfasst und wie relevant der Kontext ist, den er aus dem Vektordatensatz erfasst hat.

Die Fähigkeit, die tiefe Bedeutung der Kundenabfrage korrekt zu verstehen, ist von entscheidender Bedeutung, da ein Fehler hier zu einer schlechten Kundenerfahrung führen kann. Stell dir vor, du bist lange in der Warteschleife, drückst immer wieder die Tasten 1-5-8, und am Ende sagt der automatisierte Kundendienst, dass sie heute geschlossen haben? Oder du erklärst dein Problem im Detail einem Kundendienstmitarbeiter, und am Ende sagt er, dass er sich nicht darum kümmert und dich an jemand anderen weiterleitet?

Hier ist eine weitere Spur, die zeigt, wie gut unser LLM den Kontext aus dem Vektordatensatz für eine gegebene Kundenabfrage erfasst und wie relevant er ist. Die Fähigkeit, den genauen Kontext zu erfassen, ist von entscheidender Bedeutung, da ein Fehler hier zu einer schlechten Antwort unserer KI-Agenten führen kann.

Und hier ist die endgültige Antwort unseres KI-Agenten (für die jeweilige Abteilung) auf die Kundenabfrage. Es ist immer schön, die Funktionalität unseres Unternehmens von Anfang bis Ende testen zu können, bevor wir in die Produktion gehen, oder nicht?

Zukünftige Arbeit

- Skalierbarkeit: Wenn unsere BPO-Operationen wachsen, müssen wir unsere KI-Infrastruktur skalieren, um das erhöhte Kundenaufkommen zu bewältigen. Der Übergang zu cloudbasierten Diensten oder verteilten Computing könnte die notwendige Skalierbarkeit bieten.

- Cloud-Integration: Die Verlagerung unserer KI-Agenten und Wissensdatenbanken in die Cloud würde nicht nur die Skalierbarkeit verbessern, sondern auch die Zugänglichkeit, Redundanz und Wartung verbessern.

- LLM-Feinabstimmung: Obwohl das LLaMA-3-Modell sehr leistungsfähig ist, könnte eine Feinabstimmung des Sprachmodells auf domänenspezifische Daten die Leistung und Genauigkeit unserer KI-Agenten in ihren jeweiligen Abteilungen weiter verbessern.

- Skalierbare Vektordatenbanken: Die Implementierung skalierbarer Vektordatenbanken könnte die Geschwindigkeit und Relevanz der Wissensabfrage erheblich verbessern, so dass unsere KI-Agenten schnellere und prägnantere Antworten geben können.

- Multimodale Interaktionen: Die Aktivierung von Sprachschnittstellen und die Integration von Computer-Vision-Fähigkeiten würden eine natürlichere und nahtlosere Erfahrung für Kunden schaffen, die mit unseren KI-Agenten interagieren. (daran arbeite ich und es ist wirklich toll!)

- Kontinuierliches Lernen: Die Implementierung von Mechanismen für kontinuierliches Lernen würde es unseren KI-Agenten ermöglichen, ihr Wissen dynamisch zu erweitern und sich im Laufe der Zeit anhand von echten Kundeninteraktionen zu verbessern.

Dieses Projekt, obwohl einfach, demonstriert das Potenzial für den Aufbau eines echten KI-gestützten Unternehmens in der realen Welt. Durch den Einsatz fortschrittlicher Sprachmodelle, maßgeschneiderter Wissensdatenbanken und intelligenter Systemdesigns haben wir eine vollständig automatisierte BPO-Belegschaft geschaffen, die in der Lage ist, verschiedene kundenorientierte Geschäftsprozesse zu bewältigen.

Die Implikationen sind tiefgreifend – was wäre, wenn wir diesen Ansatz auf andere Branchen und Geschäftsbereiche anwenden könnten? Stell dir vor, KI-Agenten würden ganze Unternehmen leiten, Prozesse optimieren und eine beispiellose Servicequalität bei beispiellosen Skalen bieten. Die Möglichkeiten sind sowohl aufregend als auch zum Nachdenken anregend.

Während wir uns dieser KI-gesteuerten Zukunft zuwenden, müssen wir uns auch mit wichtigen Fragen auseinandersetzen: Welche Rolle werden die Menschen in solchen KI-zentrierten Organisationen spielen? Wie stellen wir sicher, dass wir diese Technologien auf ethische und verantwortungsvolle Weise entwickeln? Und vielleicht am wichtigsten, wie können wir die Kraft der KI nutzen, um eine bessere Welt für alle zu schaffen?