Künstliche Intelligenz & Schreiben

Wenn Ihnen KI-geschriebene Texte wie ein E-Mail-Betrug aus den 90er Jahren vorkommen, gibt es dafür einen erstaunlich menschlichen Grund.“Tauchen Sie ein in die Welt der KI-Tools und entdecken Sie, wie sie Ihre Kreativität freisetzen, Ihre Effizienz verbessern und die Content-Erstellung transformieren können.„

🤖 🤮Schrecklich, oder? Letztes Jahr habe ich einen beliebten Leitfaden auf Medium veröffentlicht, in dem ich die merkbaren Anzeichen und sprachlichen Muster von KI-generierten Texten aufzeige. Mit Abstand am häufigsten war das Wort **“Delve„.

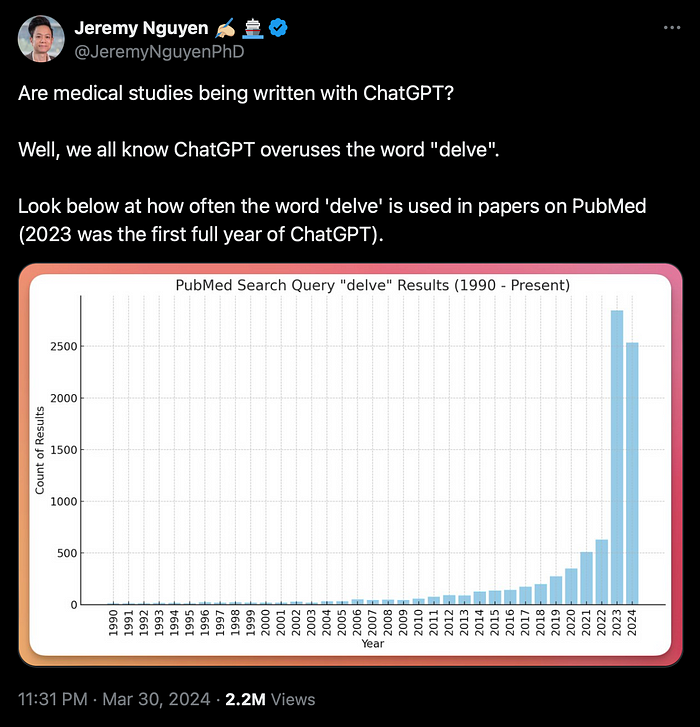

In einer kürzlichen Studie von Jeremy Nguyen PhD wurde festgestellt, dass die Häufigkeit des Wortes „delve“ in PubMed-Artikeln seit Ende 2022 um etwa 400 Prozent gestiegen ist – was mit dem Aufstieg von ChatGPT zusammenfällt.

Das „Delve“-Dilemma in KI-generierten Texten

Ich habe als Texter, Redakteur, Korrektor und als Akademiker gearbeitet, der Hunderte von Arbeiten pro Semester bewertet, und ich hatte nie zuvor das Wort „delve“ so häufig gesehen wie jetzt in belanglosen, künstlich generierten Inhalten. Aber hier ist das Problem: Wenn KI-Texte auf menschlichem Schreiben basieren, woher kommt dann diese übermäßige Verwendung des Wortes „delve“?

Ist es ein emergentes Verhalten? Oder vielleicht ein absichtlich eingefügtes Wasserzeichen von Entwicklern, damit KI-Inhalte nicht als Schulungsmaterial wieder aufgenommen werden?

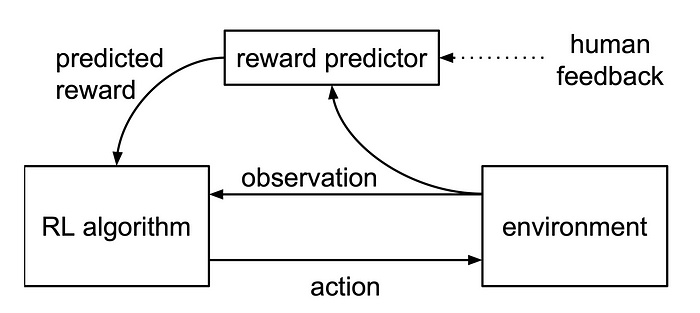

Nun, es stellt sich heraus, dass „Wo auf der Erde?“ genau die richtige Frage ist. Aber zuerst lasst uns etwas tiefer in die Entwicklung und das Training von großskaligen Sprachmodellen eintauchen und erklären, warum es notwendig ist, Modelle durch Techniken wie Verstärkungslernen aus menschlichem Feedback (RLHF) zu verfeinern.

Muster vs. Verständnis

Großskalige Sprachmodelle (LLMs) wurden anhand riesiger Textkorpora trainiert: Hunderte von Gigabyte an Daten aus Büchern, Websites, wissenschaftlichen Arbeiten, Wikipedia, Nachrichtenartikeln und sozialen Medien. Es würde ein Mensch 380 Jahre kontinuierlichen Lesens – ohne Pausen – benötigen, um die gleiche Menge an Text zu lesen, anhand derer ein KI-Modell trainiert wurde. Muster in dieser riesigen Informationsmenge ermöglichen es der KI, Texte zu generieren und Anfragen zu beantworten, aber sie versteht kein einziges Wort davon.

Die Analogie des außerirdischen Kochs

KI hat kein wirkliches Verständnis oder Wissen über die Informationen, die sie uns liefert. Kem-Laurin Lubin, Ph.D-C, gibt eine großartige Metapher, um dies zu erklären:

„Stellen Sie sich vor, Sie werden von Außerirdischen entführt und auf einen Planeten gebracht, der der Erde ähnelt. Sie werden die Rolle eines Kochs für eine wichtige Veranstaltung übernehmen, wobei Sie ungewöhnliche Zutaten aus einem außerirdischen Garten und Gewürze aus ihrer Küche verwenden. Angenommen, Sie haben noch nie gekocht und stehen nun vor den Konsequenzen eines Fehlers. Betrachten Sie KI als einen Koch, der Daten als Zutaten verwendet.“

Diese Fremdheit, diese „Andersartigkeit„, ist wichtig zu bedenken, wenn wir über Künstliche Intelligenz sprechen. Wir sollten vorsichtig sein, neuronale Netzwerke zu personifizieren oder unsere menschlichen Ontologien zu verwenden, um sie zu erklären.

Ich habe bereits über die Ähnlichkeiten und die enormen Unterschiede zwischen der Wahrnehmung der Welt durch KI und Menschen geschrieben, mit grundlegenden Unterschieden in den „Metameren“ (den unveränderlichen Dingen, die wir aus unserer Lebenserfahrung „kennen“, während KI einen Datenpunktcluster verwendet, der für Menschen unverständlich ist). Wir existieren – oder vielleicht sollte ich besser sagen „operieren“ – in parallelen, aber divergierenden Realitäten.

Das Rätsel der tickenden Uhr

Zum Beispiel weiß ein Mensch, dass die Zeiger einer Uhr stetig bewegt. Wir messen die Zeit an dieser Tatsache. Wir haben „Chronozeption„, ein Gefühl für die Ebben und Fluten des subjektiven Zeitgefühls – was es uns ermöglicht, die Dauer mit unserer Wahrnehmung und unseren zeitlichen Bezugsrahmen in unserer Sprache und unserem Denken zu verknüpfen. Oder einfacher ausgedrückt: Wir wissen, dass eine Uhr tickt, und wir „spüren“ dieses Ticken in unserem eigenen Puls und Bewusstsein für das Geschehen.

Bildgeneratoren der KI hingegen zeigen die Zeit oft als 10:10 an, da die KI keine wirklichen Erfahrungen mit der Welt hat. Die Schulungsdaten, die sie aufgenommen hat, stellen die Zeit aufgrund einer Vielzahl von Werbebildern, die Uhren bei 10:10 zeigen, unverhältnismäßig oft als 10:10 dar.

Selbst wenn sowohl Menschen als auch KI den gleichen Bildern ausgesetzt waren, sind wir Menschen nicht verwirrt, wenn die Uhr aus dem Bordmagazin die echte Zeit anzeigt und nicht die beworbene Zeit.

Die KI kann den Sprung zwischen den Klischees von Uhren in der visuellen Kultur und der Realität, dass sie nicht alle auf 10:10 eingestellt sind – oder vielmehr, sie zieht die logischere Schlussfolgerung – dass kulturelle Darstellungen, nun ja, repräsentativ sind (was enorme Auswirkungen auf rassische Vorurteile hat, aber das ist ein anderes Thema!).

Kochen nach Rezept: Ein Rezept für eine Katastrophe?

Aber was hat das alles mit „delve“ zu tun, am Ende des Tages? Nun, um Lubins Analogie fortzusetzen, ist KI ein verwirrter Koch in einer außerirdischen Küche; die Gerichte, die sie zubereitet, stammen aus einem riesigen Kochbuch, das sie nicht versteht. Sie ist ein algorithmischer „Fremder in einer fremden Welt“, der die Küche nicht probieren kann.

„Das Mischen von Daten ohne Verständnis kann zu schädlichen Ergebnissen führen, so wie das versehentliche Verwenden einer giftigen ‚außerirdischen‘ Pflanze, die einer Möhre ähnelt, aber keine Möhre ist.“ **Kem-Laurin Lubin, Ph.D-C**

Ich denke, Lubins Gedankenexperiment ist meisterhaft, in der Tradition des Turing-Tests. KI hat ein Kochbuch und alle richtigen Zutaten, aber wenn wir generative Inhalte anfordern, bitten wir sie im Grunde, neue Gerichte zuzubereiten. Sie hat keine Ahnung, ob sie essbar sind. Es erinnert mich an Rachels Versuch, ein englisches Trifle-Dessert in der Fernsehsendung „Friends“ zuzubereiten, bei dem sie die zusammengeklebten Seiten eines Kochbuchs zusammenklebt und versehentlich eine „Rindercreme“ herstellt:

Die Verfeinerung des Geschmacks der KI: Menschliches Feedback und RLHF

Demzufolge müssen wir einen Testesser zuweisen, um die KI zu schulen. Es gibt zwei Hauptmethoden, um dies zu tun: die Verwendung eines GAN (Generative Adversarial Network) oder RLHF (Verstärkungslernen aus menschlichem Feedback). Ein GAN ist, wenn zwei Netzwerke gegeneinander trainiert werden, um Belohnungen zu erhalten, um eine authentischere Ausgabe zu generieren. Um die Analogie fortzusetzen: Unsere KI-Köche treten in einem Backwettbewerb gegeneinander an und vergleichen ihre Ergebnisse mit ihren Kochbüchern, um zu sagen: „Ja, das sieht tatsächlich aus wie ein Kuchen“.

Dies ist letztendlich der Weg, den wir mit OpenAI’s Q* einschlagen, bei dem die Verstärkung so komplex und raffiniert ist, dass eine AGI in der Lage wäre, sich selbst zu verbessern (ein Konzept, das als „Superalignment“ bekannt ist).

Aber die Menschen wurden noch nicht im Stich gelassen. Obwohl KI-Systeme immer raffinierter werden, bleiben wir für den Prozess unerlässlich. Wir sind die Testesser, die Richter, die bestätigen, dass das, was die KI produziert, nicht nur technisch korrekt, sondern auch schmackhaft und für den menschlichen Verzehr geeignet ist.

Lernen von uns: Der menschliche Faktor bei der sprachlichen Verstärkung

Verstärkungslernen aus menschlichem Feedback verwendet menschliche Präferenzen, um das LLM zu leiten, um seine Ausgabe zu verfeinern. Es hilft der KI, sich mehr an unseren Geschmack anzupassen und weniger an ihre eigenen algorithmischen Tendenzen. In RLHF bewerten menschliche Prüfer die Ausgaben der KI anhand verschiedener Kriterien, wie Relevanz, Kohärenz und Engagement, und verteilen die Belohnungen entsprechend.

Modell, die mit RLHF-Techniken verfeinert wurden, können jedoch eine verzerrte Vorliebe für bestimmte Begriffe aufweisen, wie zum Beispiel „delve“, insbesondere wenn diese Prüfer eine formellere oder ansprechendere Sprache bevorzugen. Alex Hern, Tech-Autor bei The Guardian, schlägt vor, dass dies das paradoxe übermäßige Auftreten des Wortes „delve“ erklären könnte, wenn es nicht gleichmäßig in den Schulungsdatensätzen überrepräsentiert ist.

Das „Delve“-Phänomen erklärt

Laut Herns Theorie ist es aufgrund menschlichen Einflusses, dass „delve“ in KI-Ausgaben gestreut wird. Wenn Feedbackschleifen anhand wiederholter Antworten von einer begrenzten Stichprobe von Nutzern verfeinert werden, die bestimmte Phrasen oder stilistische Eigenheiten bevorzugen, lernt die KI, dass dies gewünschte Ausdrücke sind, die in der Textgenerierung repliziert werden sollten.

Diese Verstärkung verstärkt bestimmte Wörter oder Phrasen, die für Menschen ansprechend sind. Also, beim nächsten Mal, wenn Sie anfangen, die KI dafür zu beschuldigen, dass sie „zu tief eintaucht“, schauen Sie nicht weiter als zu unseren Mitmenschen. Es erinnert mich an diese Anti-Drogen-PSA-Kampagne aus den 1980er Jahren:

Doch das führt uns zu einer weiteren Frage: Warum wäre „delve“ ein menschlicher Feedback-Fehler, wenn viele Leser es als spamig empfinden?

Kulturelle Einflüsse auf die Sprachstilpräferenzen der KI

Hern schlägt vor, dass es das Ergebnis ist, dass KI-Monopole billige RLHF-Aufgaben an den globalen Süden auslagern, wobei sie günstige Arbeitskräfte in Nigeria und Kenia einstellen, um die sprachlichen Präferenzen zu überwachen und anzupassen.

Diese Nationen – mit ihren komplexen historischen Interaktionen mit der englischen Sprache aufgrund kolonialer Hinterlassenschaften – können formelle oder literarische Begriffe wie ‚delve‘ in ihrem Feedback überrepräsentieren, die die KI-Systeme dann unverhältnismäßig übernehmen.

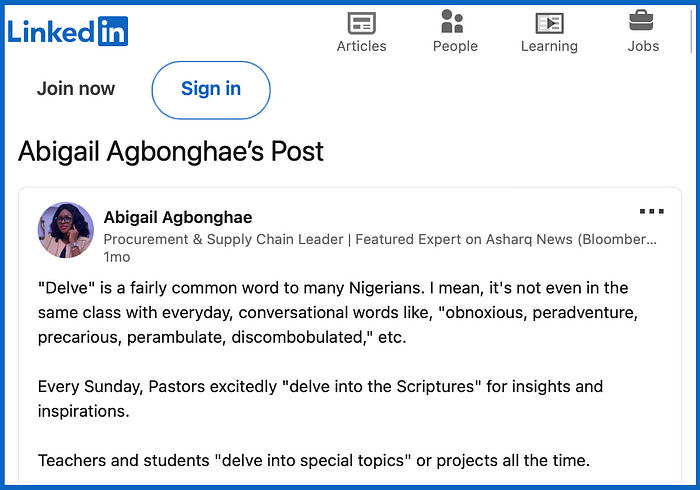

Stephanie Busari, leitende Redakteurin für Afrika bei CNN, twitterte: „Menschen, die Englisch als Zweitsprache lernen, neigen dazu, es formeller und weniger umgangssprachlich zu sprechen als in Großbritannien oder den USA.“. Mit anderen Worten, es ist oft „zu“ korrekt. Außerdem wird ‚delve‘ in Nigeria als viel gebräuchlicher angesehen:

EINBLICK: Die Auswirkungen des globalen Feedbacks auf die KI-Leistung

Dies entspricht tatsächlich meinen eigenen Erfahrungen und erklärt etwas, auf das ich gestoßen bin, als ich für eine der führenden KI-Plattformen (die hier ungenannt bleiben soll, um die Unschuldigen zu schützen) ein Beta-Tester war.

Ich testete ein neues Modell und stellte fest, dass die Ausgabe seltsame Eigenheiten hatte, wie zum Beispiel das Ansprechen von Menschen als „lieb“ in formellen Kommunikationen – nicht „Lieber Herr X„, sondern das Einfügen von „lieb“ informell in Sätzen, wie zum Beispiel „Danke lieb für Ihre Geschäftsanfrage„.

Diese Verwendung, die in einigen Kulturen zwar entzückend ist, wirkte in einem westlichen geschäftlichen Kontext jedoch fehl am Platz und veranschaulicht, wie kulturelle Nuancen in der Sprachschulung die natürliche Klangfarbe eines KI-Generators erheblich beeinflussen können.

Der Grund, warum dies geschah, war, dass das neue Modell anhand von Kundenfeedback feinabgestimmt wurde, und die Schreibplattform richtete sich an einen südasiatischen Markt, in dem solche Begriffe die Normen der Förmlichkeit und des Respekts widerspiegeln.

Da die Zielgruppe, die die KI-Nutzer ansprechen wollten, jedoch englischsprachig war, passte die Plattform letztendlich die unausgewogene Sprachstilistik an. Diese Unstimmigkeit veranschaulicht, wie die Feinabstimmung auf der Grundlage von Nutzerfeedback zu lokalisierten Sprachpräferenzen führen kann, die möglicherweise nicht universell ankommen – oder tatsächlich nicht im besten Interesse der Kunden für eine bessere Kommunikation sind.

Die Vorteile lokalisierter Sprachpräferenzen

Während geografische und kulturelle Verzerrungen im Schulungsprozess zu einer unbeabsichtigten Prägung des KI-Textgenerierungsprozesses führen können, heißt das nicht, dass sie grundsätzlich falsch oder zwangsläufig problematisch sind. Stattdessen spiegeln sie die vielfältigen Möglichkeiten wider, wie Englisch in verschiedenen Kulturen und Kontexten verwendet wird. Tatsächlich könnte RLHF dazu beitragen, umstrittene Probleme zu mildern, bei denen KI europäische Voreingenommenheiten aufgrund von Unterrepräsentation in ihrer Ausbildung zeigt, und einen inklusiveren Ansatz ermöglichen (und somit KI-Produkte für globale Ausgaben besser geeignet machen).

Um zu unserer Analogie des Kochs zurückzukehren, so wie ein geschickter Koch lernen kann, sich an verschiedene Geschmäcker anzupassen, kann KI – geleitet von vielfältigem RLHF – die Ausgaben würzen, so dass das Endprodukt für ein breiteres Publikum oder eine spezifische Kultur schmackhaft ist.