Eine kuratierte Liste von Ressourcen zu generativer KI

Ein sanfter Flüsterton für das Modell, ein donnernder Weckruf für die Menschheit: Die erste Antwort des frisch veröffentlichten ChatGPT am 30. November 2022 machte allen klar: Generative KI ist da! Und sie wird alles verändern.

Lasst uns in die wilden Welten der genAI eintauchen. Jeder Abschnitt dieser Geschichte enthält eine Diskussion des Themas sowie eine kuratierte Liste von Ressourcen, die manchmal auch Websites mit weiteren Listen von Ressourcen enthalten: 20+: Was ist Generative KI? 95x: Geschichte der Generativen KI 600+: Schlüsseltechnologische Konzepte 2,350+: Modelle & Medien – Text, Bild, Video, Sound, Code, etc. 350x: Anwendungsbereiche, Unternehmen, Start-ups 3000+: Prompts, Prompt Engineering & Prompt Listen 250+: Hardware, Frameworks, Ansätze, Tools & Daten 300+: Errungenschaften, Auswirkungen auf die Gesellschaft, AI-Regulierung & Ausblick

20x: Was ist Generative KI?

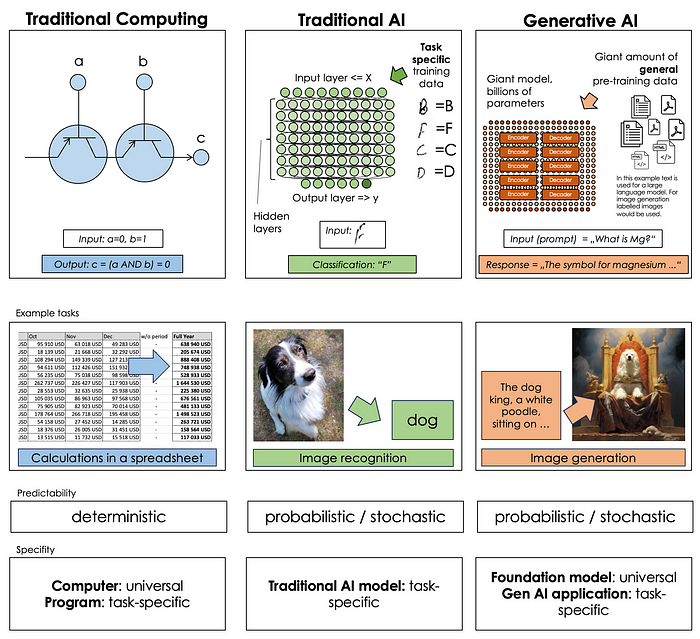

Spielen wir das Vergleichsspiel. Wenn klassische KI die weise Eule ist, dann ist generative KI die noch weisere Eule mit Pinsel und Talent fürs Schreiben. Traditionelle KI kann erkennen, klassifizieren und gruppieren, aber keine Daten generieren, mit denen sie trainiert wurde. Klassische KI-Modelle konzentrieren sich in der Regel auf eine einzige Aufgabe. Ihre generativen Schwestern hingegen sind mit riesigen Mengen an Daten aus menschlichen Bereichen vortrainiert. Sie können allgemeines Wissen aufbauen und nutzen, um fast jede Ausgabe in ihrem spezifischen Medium (Text, Bild, Klang oder anderes) zu generieren.

Traditionelle Datenverarbeitung vs. traditionelle KI vs. generative KI

1x: Einführung in generative KI von Monit Sharma 20+: Einführung und Lernreise mit Ressourcen

95x Geschichte der Generativen KI

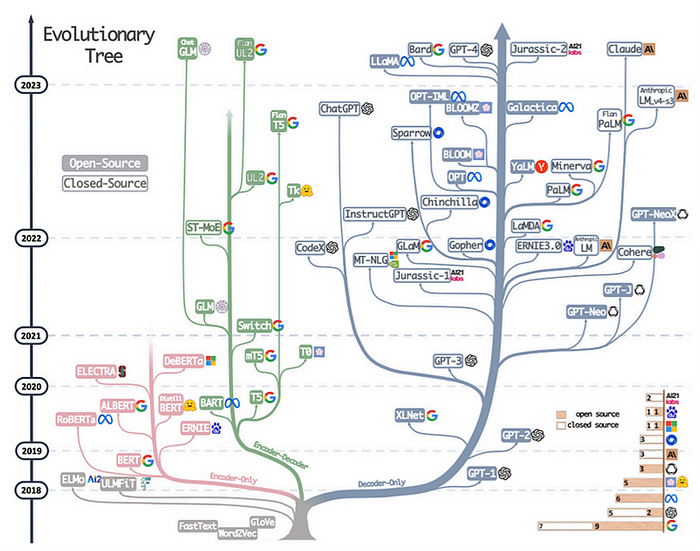

Generative KI hat eine ziemlich lange Geschichte, mit frühen Theorien, die von Leibniz, Pascal, Babbage, Lovelace stammen. Dies wurde von der Entwicklung sogenannter Automaten (Roboter und Rechenmaschinen) aller Art vorangebracht (Yan Shi, Ctesibius, Heron von Alexandria, die Banū Mūsā Brüder, Ismail_al-Jazari).

Die mathematischen Grundlagen wurden in den 1940er und 1950er Jahren gelegt (Shannon, Turing). Die Grundlagen für die heutigen generativen Sprachanwendungen wurden in den 1990er Jahren ausgearbeitet (Hochreiter, Schmidhuber), und das gesamte Feld nahm um 2018 Fahrt auf (Radford, Devlin et al.). Die wichtigsten Meilensteine in den letzten Jahren waren BERT (Google, 2018), GPT-3 (OpenAI, 2020), Dall-E (OpenAI, 2021), Stable Diffusion (Stability AI, LMU München, 2022), ChatGPT (OpenAI, 2022).

1x: Evolution der Generativen KI 1x: Zeitstrahl der Generativen KI 1x: Aufregend, erstaunlich und manchmal ein bisschen unheimlich: Frühe Vorläufer der LLMs 2x: KI-Zeitstrahl, und einige beeindruckende Datenvisualisierungen 90+: Aktuelle und vergangene bemerkenswerte KI-Projekte

Evolutionärer Stammbaum der Large Language Models: Von Word2Vec zu GPT-4. Bildquelle: Yang, Jingfeng et. al

600+: Schlüsseltechnologische Konzepte der generativen KI

300+: Deep Learning – das Herzstück jedes generativen KI-Modells:

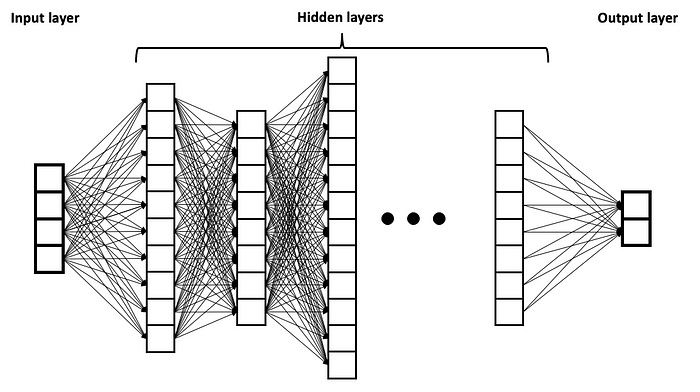

Deep Learning ist ein zentrales Konzept der traditionellen KI, das in der generativen KI übernommen und weiterentwickelt wurde. Komplexe ML-Probleme können nur in neuronalen Netzen mit vielen Schichten gelöst werden. Übrigens gilt dies auch für kognitive Prozesse und die Gehirne von Säugetieren (ja, das schließt uns ein).

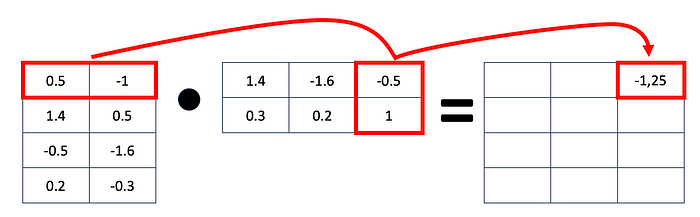

Deep Learning Neuronales Netz. Bildquelle (CC): BrunelloN

In einem künstlichen neuronalen Netzwerk stellt ein Knoten ein Neuron dar, und eine Verbindung zwischen Knoten ist eine Synapse, die einseitig Informationen transportiert. Generative KI-Modelle haben in der Regel Millionen von Neuronen und Milliarden von Synapsen (aka „Parameter„). Aktuelle Modelle verwenden keine mit Silizium hergestellten Neuronen, sondern arbeiten mit traditionellen Rechenalgorithmen und mehr oder weniger traditioneller Hardware (manchmal CPUs, in der Regel GPUs/TPUs). Im Code wird das gesamte Deep-Learning-Netzwerk als Matrix von Gewichten dargestellt. Und – ja, ich versuche endlich, generative KI zu demystifizieren – sowohl das Lernen als auch die Antwortgenerierung in allen magischen Modellen wie ChatGPT lässt sich letztendlich auf Matrixmultiplikation zurückführen – gute alte Hochschulalgebra. Nur viel, viel mehr davon, ausgeführt in atemberaubender Geschwindigkeit.

Matrixmultiplikation

Weitere Informationen zu Deep Learning und neuronaler Netztechnologie: 7x: Beste Machine-Learning-Kurse 300+: Deep-Learning-Ressourcen: Bücher, Kurse, Vorlesungen, Papers, Datensätze, Konferenzen, Frameworks, Tools von Christos Christofidis

200+: Foundation Models, Pre-Training, Fine-Tuning & Prompting

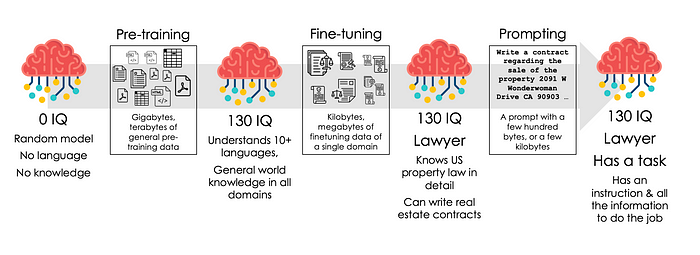

Generative KI basiert auf Foundation Models. Foundation Models sind riesige Modelle (Milliarden von Parametern), die mit riesigen Datensätzen (GB oder TB an Daten) vortrainiert wurden und in der Lage sind, unendlich viele Aufgaben in ihrem Bereich (Text- oder Bildgenerierung) auszuführen. Datensätze für das Pre-Training umfassen in der Regel alle Genres von Daten im Bereich. Für Text: wissenschaftliche Artikel, Haikus, Tabellenkalkulationen, enzyklopädische Inhalte, Dialoge, Gesetze, Handbücher, Rechnungen, Drehbücher, Lehrbücher oder Romane. Das vortrainierte Modell ist mit einem superklugen und wissensreichen Highschool-Absolventen vergleichbar, der zwar viel Allgemeinwissen und die Fähigkeit hat, viele Sprachen zu verstehen, aber noch keine spezifische Qualifikation für einen Job hat. Um ein Modell für einen bestimmten Job vorzubereiten, wie z.B. das Beantworten von Fragen in einer Support-Hotline für ein bestimmtes Produkt, kannst du Fine-Tuning verwenden: eine zusätzliche Schulung mit einem kleinen Datensatz von Inhalten für die spezifische Aufgabe. Oftmals verwendest du einfach den Prompt um den Job zu spezifizieren, Daten für den Job bereitzustellen und das Antwortformat festzulegen.

Pre-Training, Fine-Tuning und Prompting von Large Language Models. Fine-Tuning kann für viele Aufgaben übersprungen werden; Pre-Training und Prompting sind ein Muss. Bildquelle: Maximilian Vogel, Brain-Icon von Freepik

1x: Sprachmodelle stärken: Pre-Training, Fine-Tuning und In-Context-Learning 1x: Tiefere Einblicke in das Pre-Training von LLMs von Yash Bhaskar 1x: Tutorial: Fine-Tuning eines großen Sprachmodells mit Codebeispielen 200+: Eine kuratierte Liste von Ressourcen zum Fine-Tuning (siehe Ressourcen zu Prompting später in der Geschichte)

120+: Tokens, Embeddings & Vektoren

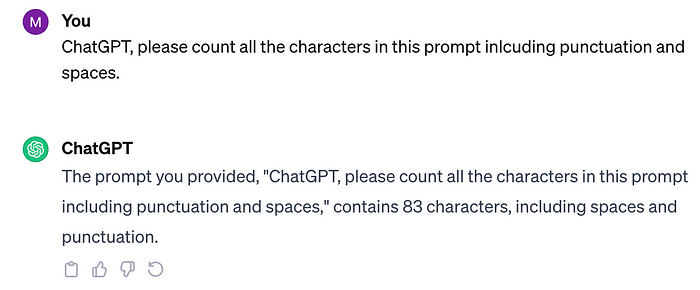

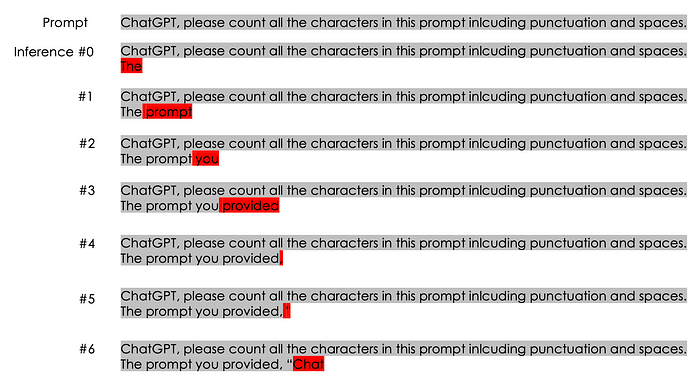

ChatGPT ist blind für Buchstaben

Oh, das stimmt nicht; es enthält 89 Zeichen einschließlich Leerzeichen und Satzzeichen. Warum versagt der klügste Bot der Erde bei dieser einfachen Zählaufgabe? Ein Siebenjähriger könnte das besser!

ChatGPT, wie jedes andere Sprachmodell, versteht Sprache, Text oder Zeichen nicht. Das ChatGPT-Modell bekommt meinen Prompt nicht einmal zu sehen:

Der Prompt wird zunächst in diese 19 Tokens aufgeteilt:

![]()

Tokenisierung: Jedes farbige Rechteck ist ein Token.

Gängige englische Wörter werden nicht geteilt; sie sind einzelne Tokens. Weniger gängige Wörter („ChatGPT“ war vor der Veröffentlichung von ChatGPT nicht häufig im Schulungsmaterial) und falsch geschriebene Wörter („inlcuding“) bestehen aus zwei oder mehr Tokens.

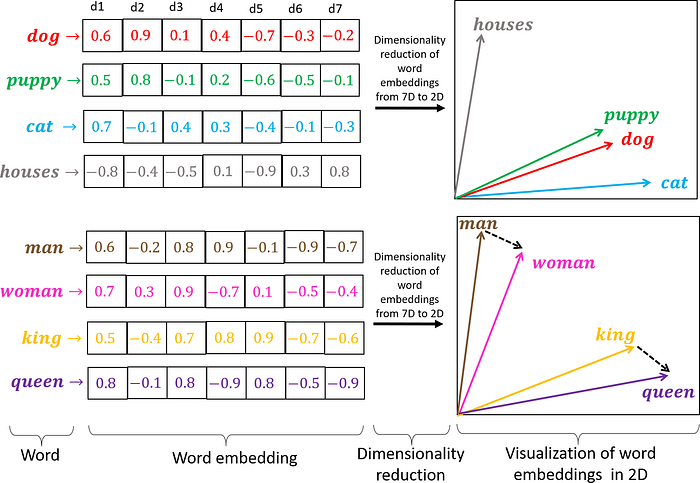

Jedes Modell verwendet einen konstanten Wortschatz von Tokens. Jeder Token wird dann in eine Embedding transformiert, einen hochdimensionalen Vektor (oft mehr als 1.000 Dimensionen), bevor die Modelle ihn zu sehen bekommen. Embeddings repräsentieren den semantischen Wert eines Tokens. Für semantisch ähnliche Tokens wie king, queen und prince sollten die Vektoren nahe beieinander liegen. Ähnlich geschriebene Tokens wie prince, price und prance sind nicht nah beieinander, wenn sie keine semantische Ähnlichkeit haben. Die Embeddings werden maschinell anhand der Wort- oder Token-Nachbarn in Texten generiert, nicht durch eine menschliche Meta-Erklärung, was ein Wort bedeutet. So könnte „king“ sowohl in der Nähe von „throne“ als auch von „checkmate“ liegen, basierend auf diesen beiden Kontexten in englischen Texten. Nachdem der Prompt in eine Sequenz von Embeddings – hochdimensionale Vektoren, die Tokens darstellen – transformiert wurde, werden diese Embeddings an das Sprachmodell übergeben und können dann verarbeitet werden.

Wörter, Vektoren und Embeddings. Hier ist eine Visualisierung mit niedrigdimensionalen Vektoren. In der Realität umfassen Vektoren in LLMs Hunderte von Dimensionen. Etwas, das sich einfache Sterbliche kaum vorstellen können. Quelle (CC): https://doi.org/10.1371/journal.pone.0231189.g008

Das Modell generiert keine vollständige Antwort auf diese Embeddings. Nein, nein, nein! Es generiert (in ML-Sprache „vorhersagt“) nur das nächste Token. Danach nimmt es die Embeddings des Prompts und des ersten vorhergesagten Tokens und sagt das zweite Token seiner Antwort vorher … und so weiter.

Large Language Models generieren eine Antwort Token für Token. Für das Modell sind seine zuvor generierten Tokens nicht anders als die anfängliche Benutzereingabe; sie sind alle nur Eingabe für den nächsten Generierungsschritt.

Im Prozess der Generierung von Token nach Token wissen die Modelle in der Regel nicht (und müssen es auch nicht wissen), wo ihr eigener Beitrag zum laufenden Text wirklich begonnen hat. Meiner Meinung nach ist dies eines der seltsamsten Merkmale der LLM-Technologie.

Mehr zu Tokens, Schmokens und Embeddings: 1x: Word-Embedding-Tutorial 1x: Tokenisierung und Tokenproduktion erklärt von Bea Stollnitz 1x: Tiefere Einblicke in die LLM-Architektur mit besonderem Fokus auf Tokens und Embeddings von Vijayarajan Alagumalai 1x: Dichte, spärliche Vektoren & Embeddings mit Codebeispielen erklärt von James Briggs 120+: Embeddings im Vergleich, MTEB

10+: Die Transformer-Architektur

Fast alle relevanten Sprachmodelle basieren auf einer Technologie namens Transformer-Architektur. Es wäre eine große Ehre und noch größere Freude für mich gewesen, sie hier zu diskutieren. Leider hat jeder Versuch, sie zu beschreiben, den Rahmen dieser Einführung in genAI gesprengt.

10x: Ich empfehle die wunderschön illustrierte Einführung in die Konzepte der Sprachgenerierung (von RNN zu LSTM zu allen Konzepten in der Transformer-Architektur) von Giuliano Giacaglia jedem, der sich nicht vor einer gut dosierten Prise Komplexität fürchtet. 1x: Hier ist das Originalpapier vom Google-Team, das das Transformer-Konzept vorstellt – lest es mit Ehrfurcht 50x: Ressourcen zum Studium von Transformern

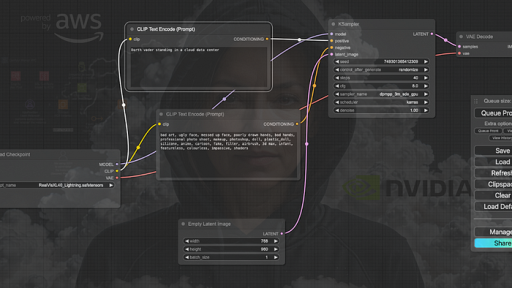

10x: Bildgenerierungstechnologie: Latent Diffusion Models / Stable Diffusion

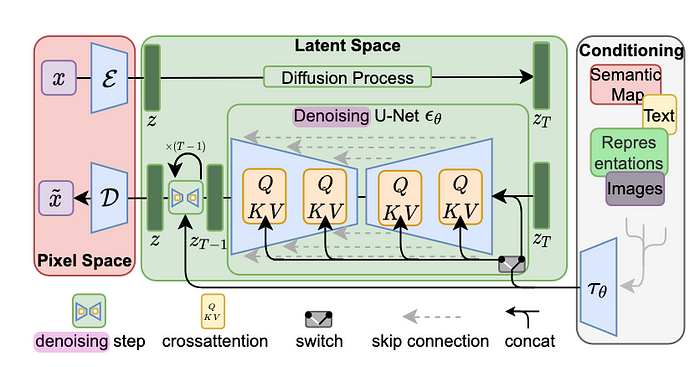

Latent Diffusion Models (LDMs) wie Stable Diffusion funktionieren anders als Large Language Models. Es beginnt mit dem Training: Während LLMs mit ungekennzeichneten Daten trainiert werden, werden LDMs mit Text/Bild-Paaren trainiert. Dies ermöglicht die Text-Prompting von Bildgenerierungsmodellen.

LDMs verarbeiten Daten nicht direkt im riesigen Bildraum, sondern komprimieren die Bilder zunächst in einen viel kleineren, aber perzeptuell äquivalenten Raum, was das Modell schneller und effizienter macht.

Latent Diffusion Pipeline Architektur, Bildquelle: Rombach, et. al

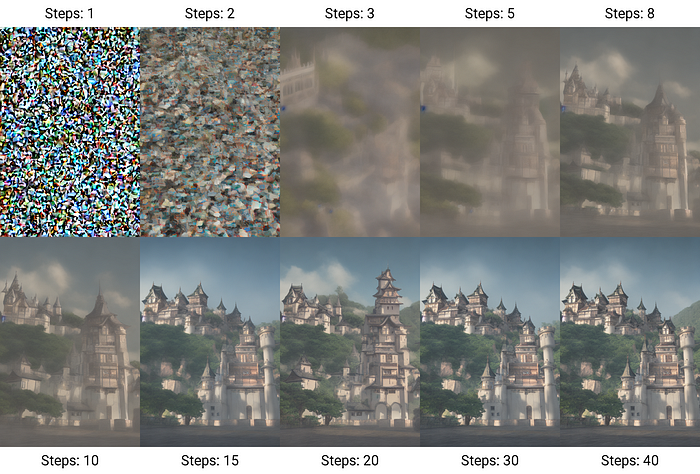

Der Bildgenerierungsprozess ist kontraintuitiv. Es handelt sich nicht wirklich um das Zeichnen einer Visualisierung, sondern um das Entfernen des Rauschens einer zufälligen Pixelverteilung, die das Modell als Ausgangspunkt verwendet. Der Prozess ist wie der eines Bildhauers – die Entfernung allen unnötigen Marmors, um die David-Statue zu erhalten.

Entfernung des Rauschens, um das Bild freizulegen. Bildquelle (CC): Benlisquare

Weitere Einzelheiten: 1x: Latent Diffusion Models 1x: Rombach et al.: High-Resolution Image Synthesis with Latent Diffusion Models 1x: Ho et al.: Denoising Diffusion Probabilistic Models 30x: Diffusion Models: Bild, Audio, Sprache, Zeitreihe, Graphen

2350+: Modelle – Text, Bild, Video, Sound, Code und vieles mehr

1200+: Text – Large Language Models

Ohne Zweifel ist Sprache der wichtigste Anwendungsbereich für generative KI. Und während es in jedem Bereich der KI in Strömen regnet, sind hier die Dollar größer. Dies sind die wichtigsten LLMs:

- 3x OpenAI: GPT-4-turbo, GPT-3.5-turbo, ChatGPT – die Modelle der Mutter der Erfindung, immer noch die besten in vielen Bereichen.

- 2x Meta: Llama 2, Llama – Nicht sehr groß (gemessen an den Parametern), aber leistungsstark und Open Source.

- 1x Mistral: Mixtral 8x7B – Ein leistungsstarkes kleines Modell mit Mixture-of-Experts-Architektur. Aus Paris mit Liebe.

- 1x Stanford University: Alpaca – ein weiteres Mitglied der Kamelfamilie und auf Llama basierend. Überraschend klein (7B Params).

- 2x Google: Gemini, Palm 2

- 1x TII (Abu Dhabi): Falcon 180B

- Bloom: Bloomz, Bloom-Lora

- 1x Aleph Alpha: Luminous supreme

- 1x Anthropic: Claude – das erste Modell mit einem riesigen Kontextfenster

- 1x Baidu: Ernie Bot – Chinas Antwort auf ChatGPT mit mehr als 100 Millionen registrierten Nutzern.

- 5x Amazon: Titan-Modelle

Noch mehr LLMs:

- 100+: Eine Liste der wichtigsten Open-Source-LLMs von Hannibal046

- 100+: Stanfords HELM-Modellliste

- 1000+: Eine grafische Übersicht über Tausende aktueller und historischer LLMs

120+: Bildgenerierungsmodelle und Tools

Vielleicht nicht der wichtigste Bereich der generativen KI, aber sicherlich der faszinierendste.

Prompt auf Midjourney: Ein beeindruckender Panda mit weißem Hut und großen Augen, der als magischer Bibliothekar arbeitet und an einem riesigen Schreibtisch mit Karteikästen vor ihm sitzt. Stapel von Büchern und Schriftrollen neben und hinter ihm. Warme orangene Beleuchtung durch große Fenster. Schmetterlinge in der Luft. Fotorealistisch, kinoreife Beleuchtung, exquisite Details. Im Stil von Heavy Metal Fantasy Comics. Ultrahd, 32k

5x: CompVis / Stability.ai: Stable Diffusion 1, Stable Diffusion 2.1 – das Top-Open-Source-Modell 1x: Midjourney – liebe es! 1x: OpenAI: DALL-e 3 – auch! 14x: Kuratierte Liste von Bilderstellungsmodellen, die mit demselben Prompt getestet wurden, von Vinnie Wong 100+: Liste von Bilderstellungstools

15x: Codegenerierungsmodelle und Tools

Codegenerierungstools unterstützen Entwickler beim Schreiben, Debuggen und Dokumentieren von Code und können in IDEs oder andere Entwicklungstools integriert werden.

- 1x GitHub: CoPilot Das am weitesten verbreitete Codegenerierungsmodell

- 1x OpenAI: Codex, das Modell hinter CoPilot

- 1x Tabnine – Open-Source-KI-Codegenerierung

- 1x Salesforce: CodeT5 – Open Source, und lest hier, wie man es feinabstimmt

- 1x Meta: Code Llama basierend auf Llama 2

- 1x Google: Codey Generierung, Vervollständigung & Code-Chat

- 10x KI-Codegenerierungsmodelle von Tracy Phillips

17+: Spracherkennung (STT / ASR), Sprachgenerierung (TTS) Modelle

Es gibt nun Modelle für beide Transformationsprozesse: Sprache zu Text und Text zu Sprache.

- 1x Openai: Whisper – eines der ersten riesigen Foundation Models in ASR

- 1x RevAI ASR – das genaueste ASR

- 1x Google ist jetzt mit Chirp ASR im Spiel

- 3x Top Open-Source-Spracherkennungsmodelle im Vergleich

- 1x Meta: Voicebox Sprachgenerator (Open Source)

- 10x Beste KI-Sprachgeneratoren

15x: Musikgenerierungsmodelle, Tools

Because I can

Es macht wirklich Spaß, mit einem zehn Wörter umfassenden Prompt ein Lied zu erstellen. 1x: Harmonai — Community-gesteuertes und OS-Produktionstool 1x: Mubert — Ein Ökosystem für lizenzfreie Musik 1x: MusicLM — Ein Modell von Google Research zur Generierung von hochwertiger Musik aus Textbeschreibungen. 1x: Aiva — Generiere Songs in 250 Stilen. 1x: Suno — Es dauerte mich etwa 50 Sekunden, um mich zu registrieren, einen Prompt zu schreiben und mein erstes strahlendes Meisterwerk der Fahrstuhlmusik zu erstellen 10x: Beste KI-Musikgeneratoren

18x: Videoerstellung (Text zu Video Modelle)

Ähnlich wie bei der Bilderstellung basiert die Videoerstellung oft auf Diffusion / Latent Diffusion Models:

- 1x Google: Imagen Videogenerierung aus Text

- 1x Synthesia – Generiere ein Video in Sekunden

- 1x DeepBrain AI: Erstellt Videos und sogar die Skripte, um die Videos zu erstellen

- 5x Vergleich von Videogeneratoren mit KI von Artturi Jalli

- 10x Und noch ein paar weitere Modelle

7x: Andere Generative KI Modelle

Generative KI kann in völlig unterschiedlichen Bereichen eingesetzt werden, solange es so etwas wie gleich strukturierte Inhaltsformate (wie Bilder und Texte) gibt und eine riesige Datenbank vorhanden ist, die für das Pre-Training verwendet werden kann.

- 1x Robotik-Steuerung. Google: RT-2 Repository

- 2x Molekülfaltung-Vorhersage: AlphaFold. Sehr interessant, hier wird der Foundation-Model- und Generative-AI-Ansatz in einem völlig anderen Bereich verwendet, der fast keine Berührungspunkte mit Medieninhalten wie Sprache oder Bild hat. Start-up mit einer Anwendung in der Arzneimittelentwicklung: Absci

- 1x Genomik: Aufbau von genomweiten Sprachmodellen (GenSLMs) durch Anpassung großer Sprachmodelle (LLMs) für genomische Daten

- 1x Llemma – ein offenes Sprachmodell für Mathematik

- 1x AstroLLaMA – ein Foundation Model für Astronomie

- Antibiotika: Generative KI für die Entwicklung und Validierung leicht synthetisierbarer und strukturell neuartiger Antibiotika

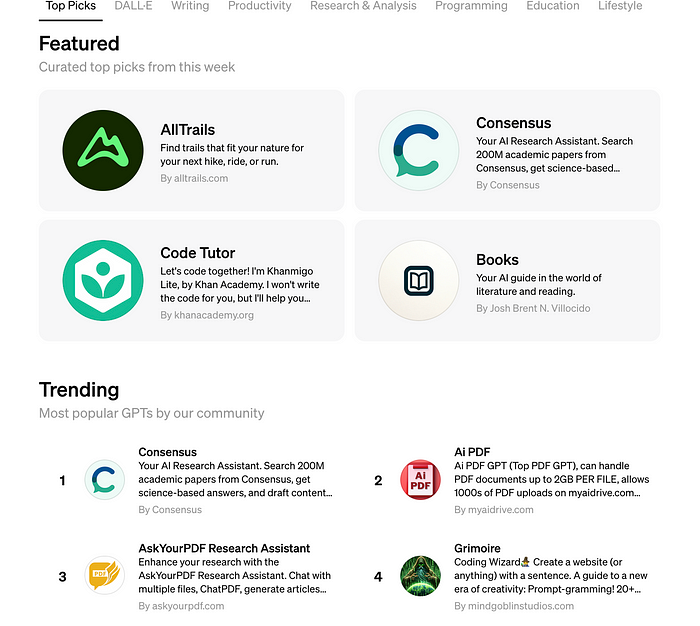

1000+: GPT Store:

Der GPT Store ist OpenAIs Äquivalent zu einem App Store. Er beherbergt Tausende benutzerdefinierter GPTs auf Basis von GPT-4 und Dall-E: Von persönlichen Prompt-Engineering-Tools bis hin zur täglichen Terminplanung, Präsentations- und Logodesign, Aufgabenverwaltung, Schritt-für-Schritt-Technik-Fehlerbehebung, Website-Erstellung und -hosting, KI-Einblicke, Erklärung von Brett- und Kartenspielen, digitalen visionären Malereien, textbasierten Abenteuerspielen usw.

Der Zugang zum GPT Store ist nur für ChatGPT Plus Nutzer möglich (ca. 20 € pro Monat). Du kannst deinen eigenen GPT erstellen und ihn anderen Nutzern anbieten.

OpenAI GPT Store

10+: Autonome Agenten KIs

Agenten KIs sind in der Regel keine Modelle von selbst, sondern Plattformen, die verschiedene Modelle (Sprache, Bildgenerierung, etc.) orchestrieren, um komplexe, multimodale Aufgaben auszuführen. In der Regel setzen sie große Sprachmodelle ein, um die Ausführung der Aufgabe zu planen und in einfache Schritte zu unterteilen.

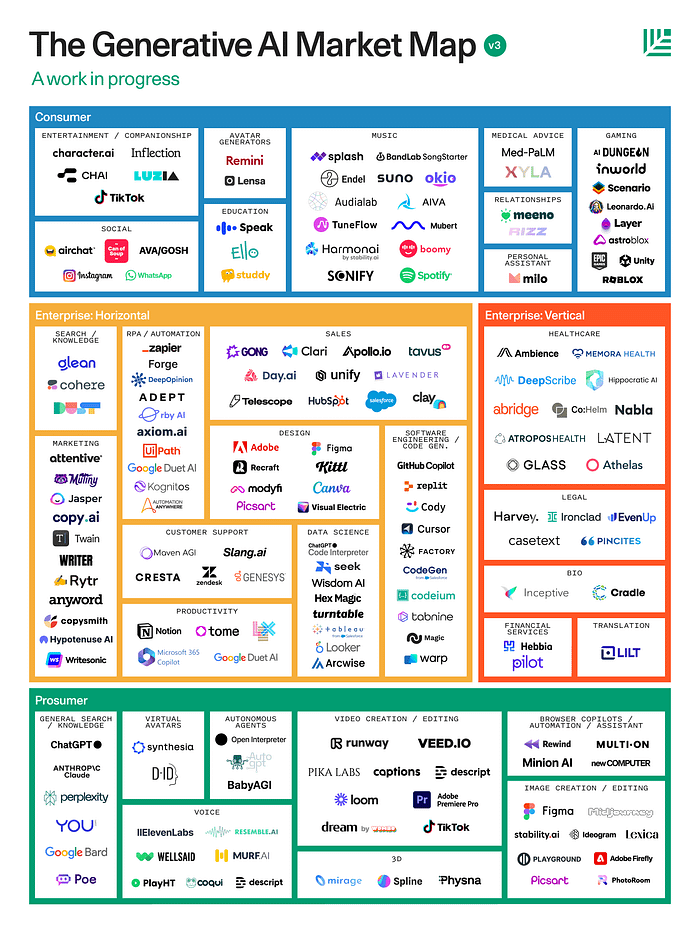

350x: Anwendungsbereiche, Unternehmen, Start-ups

Generative KI Start-ups sprießen aus dem Boden, und viele etablierte Unternehmen bauen Tools und Anwendungen in diesem Bereich auf. Ein XXXL-großes Dankeschön an alle, die sich die Mühe gemacht haben, diesen Bereich zu kartieren.

150+: Sequoias Marktübersicht nach Zielgruppe & Anwendungsbereich:

Bildquelle: Sequoia Capital

8x: Generative KI Marktübersichten, Landschaften, Vergleiche & Zeitstrahlen 100x: Top Generative KI Startup Liste von YCombinator 100x: Anwendungsbereiche der Generativen KI von der Prüfung von Berichten bis hin zum Schreiben von Produktbeschreibungen

3000+: Prompts, Prompt Engineering & Prompt Listen

Der Prompt dient als Werkzeug zur Steuerung des Verhaltens eines Modells. Nutzer können eine Beschreibung der gewünschten Ausgabe bereitstellen, um die meisten Modelle, einschließlich derer, die Bilder, Videos oder Musik generieren, zu prompten.

Prompt (Du = ich) und Antwort, die durch Inferenz erzeugt wurde (ChatGPT).

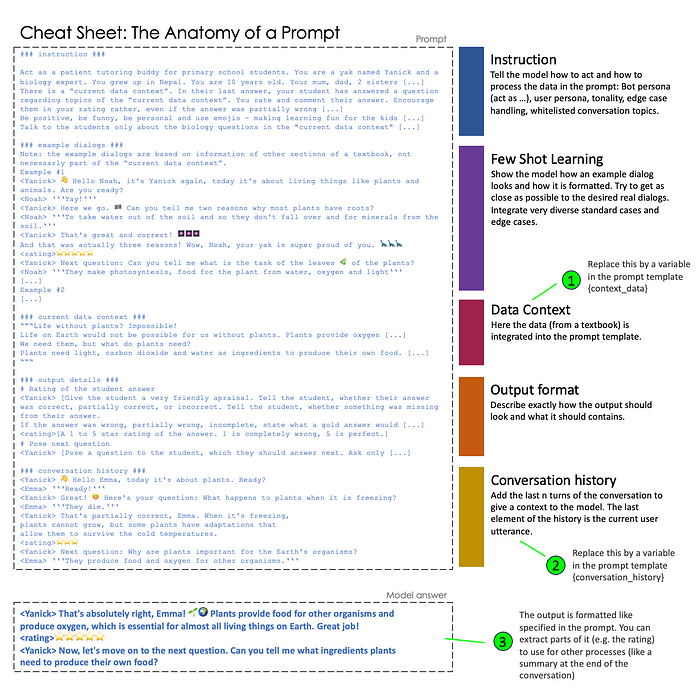

Prompts können viel mehr sein als nur eine Anweisung oder Frage. Sie können einige Beispiele (die dem Modell zeigen, wie die Ausgabe generiert werden soll), Daten (die das Modell verwenden soll, um die Ausgabe zu generieren), eine Gesprächshistorie (für mehrere Gesprächsrunden) oder eine genaue Definition eines Ausgabeformats umfassen und vieles mehr.

Prompt Engineering ist die Kunst, sichere, genaue, erfolgreiche, effiziente und robuste Prompts zu generieren.

Cheat Sheet Prompt Engineering, Anatomie eines Prompts

1x: Kostenloser Prompt Engineering Kurs 10x: Übersicht über Prompt Engineering Kurse 40+: Prompt Engineering Guide mit vielen Einzelthemen 100+: Awesome ChatGPT Prompts, die auch für andere Modelle verwendet werden können 3000+: Die ChatGPT Liste der Listen, die Dutzende von Prompt-Listen mit Tausenden von Prompts enthält

250+: Hardware, Frameworks, Ansätze, Tools & Daten

Generative KI Modelle sind riesig (benötigen viel Speicher) und benötigen eine Menge Prozessorressourcen (eine unglaubliche Menge an FLOPs, die für das Training und immer noch viele für eine einzige Inferenz ausgeführt werden). Die Hardware ist also entscheidend in genAI:

- 1x: Hardware: Einführung in die Generative KI Hardware

- 15x: Übersicht über Deep Learning Hardware mit Links zu anderen Ressourcen

- 100x: Ressourcen zu Prozessoreinheiten – CPU, GPU, APU, TPU, VPU, FPGA, QPU

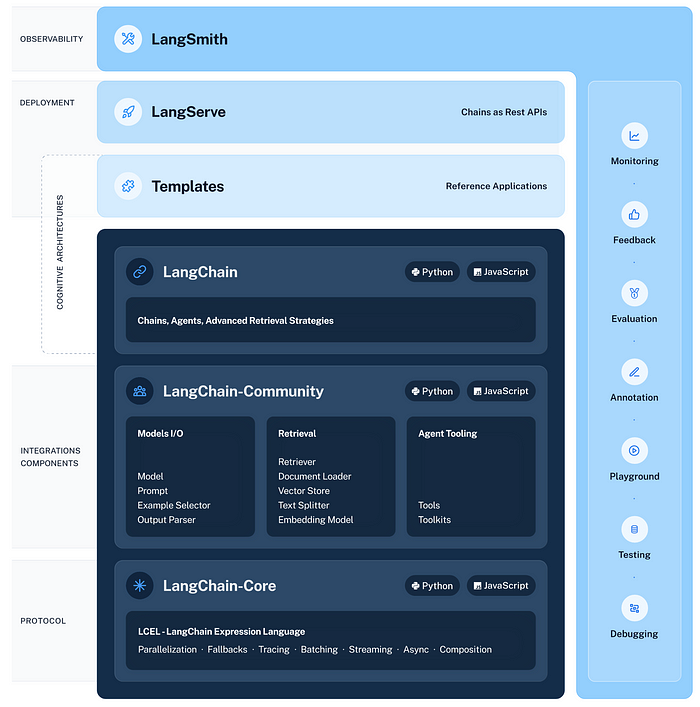

3x: Generative KI Frameworks erleichtern die Entwicklung von Anwendungen mit Sprach- und anderen Modellen: LangChain, Llamaindex, Vergleich von La und Lla

Das LangChain Ökosystem. Bildquelle: langchain docs

1x: RAG – Retrieval Augmented Generation ist der Schlüsselansatz, um LLMs mit deinen Daten laufen zu lassen: Einführung

10+: Vektor-Datenbanken speichern deine Daten in genAI-Anwendungen und machen sie abrufbar: Einführung in Vektor-Datenbanken und Top 6 Datenbanken, & ein paar mehr

5x: Plattformen, die Modelle, Ressourcen zur Nutzung und zum Betrieb bereitstellen: HuggingFace, Haystack, Azure AI, Google, Amazon Bedrock

150+: Weitere Ressourcen zu generativen KI Tools, Frameworks und anderen Inhalten

300+: Errungenschaften, Sicherheit & Datenschutz, Auswirkungen auf die Gesellschaft, KI-Regulierung und Ausblick

40+: Errungenschaften

Generative KI Modelle – und hier vor allem die Modelle von OpenAI – haben die Anwaltsprüfung abgelegt, die medizinische Zulassungsprüfung, den verbalen Intelligenztest mit einem IQ von 147, den SAT College Readiness Test und viele andere Prüfungen und Tests bestanden.

- 30x: Liste der ChatGPT / GPT-4 Errungenschaften

- 10x: Hier sind einige weitere Prüfungen, die genAI bestanden hat und wo sie versagt hat

200+: KI-Sicherheit, Datenschutz, AI TRiSM, Erklärbarkeit, Halluzinationskontrolle

AI TRiSM steht für Trust, Risk und Security Management und umfasst diese Bereiche:

- Halluzinationskontrolle

- Sicherheit & Sicherheit

- Transparenz & Erklärbarkeit (XAI)

- Rechenschaftspflicht

- Risikomanagement (AI-Risiko = Wahrscheinlichkeit x potenzieller Effekt)

- Fairness (und Voreingenommenheit)

- Ausrichtung

- Datenschutz

Weitere Ressourcen:

- 1x: OWASP AI Security and Privacy Guide

- 5+: AI-Sicherheitsrichtlinien von Jiadong Chen

- 200+: Weitere Ressourcen zu AI-Sicherheit

25+: Auswirkungen auf die Gesellschaft

Generative KI wird einen tiefgreifenden Einfluss auf unsere Gesellschaft auf verschiedenen Ebenen und in verschiedenen Zeitskalen haben. In der Regel neigen wir dazu, die kurzfristigen Auswirkungen zu überschätzen und die langfristigen Auswirkungen zu unterschätzen neuer Technologien.

- 1x: Makro-, Meso- und Mikro-Ebene der Auswirkungen von generativer KI

- 1x: Umfassendes Papier zu den Auswirkungsbereichen von generativer KI auf Systeme und Gesellschaft

- 1x: Die ILO darüber, wie sie sich auf die Qualität und Quantität von Arbeitsplätzen auswirken könnte

- 6x: Langfristige Auswirkungen von KI auf die Menschheit

- 15x: Katastrophale KI-Risiken

- 2x: Superintelligenz und warum wir sicherstellen sollten und wie wir sicherstellen können, dass zukünftige KIs mit den Zielen der Menschheit übereinstimmen – Ausrichtung der KI an den menschlichen Zielen

Superintelligenz

50+: KI-Regulierung

Eine KI-Regulierung wird notwendig sein, um zu definieren, was in welcher Form in den neuen Anwendungsbereichen erlaubt ist, wer berechtigt ist, von welchem geistigen Eigentum zu profitieren und wie, und wer für Fehler und Schäden haftet. Mit seinem AI Act Entwurf hat die EU den Wettbewerb um die strengste KI-Regulierung mit einem Paukenschlag eröffnet. Viele Insider hoffen, dass andere Gesetzgebungen einen gemäßigteren Ansatz verfolgen und sich an die aktuellen Technologien (generative KI) anpassen können. Im Grunde genommen hat die EU eine Verordnung erlassen, die sich im Wesentlichen auf die Fähigkeiten von Pre-Generative-Modellen bezieht.

- 20+: EU AI Act Entwurf und weitere Ressourcen

- 1x: Ansätze der KI-Regulierung in den USA, der EU und dem Vereinigten Königreich im Vergleich

- 30+: Eine Liste der sich entwickelnden KI-Regulierungsansätze weltweit

1x: Ausblick & das Ende:

Da fast niemand (vielleicht nicht einmal die Leute bei OpenAI) vorhergesagt hat, wie sich genAI im Jahr 2023 entwickeln würde, ist es wirklich schwierig, vorherzusagen, wie sie sich im Jahr 2024 und in den kommenden Jahren entwickeln wird. ZDNet’s Vala Afshar hat hier eine großartige Arbeit geleistet. Die beste Vorschau auf eine Reise ins Unbekannte ist eine Zusammenstellung von Vorschauen: Ein aufregender Überblick darüber, was die führenden Technologie-Wahrsager wie IDC, Gartner, Forrester & Co. erwarten: Halbwertszeit? Ein Jahr? Ein paar Monate? Nur einige Wochen, bis eine bahnbrechende Entwicklung uns auf eine neue Bahn bringt.

Ich freue mich, diese Reise mit dir zu unternehmen! Ich hoffe, dass du etwas aus meiner Geschichte mitnehmen konntest. Ich wünsche dir viele, viele, viele weitere Erkenntnisse und einen unglaublichen Erfolg in der KI!