Im Juli habe ich in meinem einjährigen Experiment untersucht, wie sich KI für verschiedene hobbyrelevante Aktivitäten einsetzen lässt. Dabei ging es darum, KI für die automatisierte Marktforschung zu nutzen, um Ideen für ein Produkt für meinen Etsy-Shop zu entwickeln – und zwar mit aktuellen Daten.

Kann ich einen #KIAgenten erstellen, der automatisch Datenanalysen und Marktforschung durchführt und Startideen für ein Produkt liefert, das ich entwerfen möchte?

Kann dieser Agent einen mehrstufigen Prozess durchlaufen, bei dem verschiedene Informationen geprüft und Entscheidungen auf Basis von qualitativen und quantitativen Daten getroffen werden?

Kann dieser Agent diesen Prozess automatisch zu einer von Ihnen gewählten Zeitplanung durchlaufen und Ihnen die Ergebnisse in einem verständlichen Format zurückgeben?

Ich würde dieses Projekt als sehr erfolgreich bewerten. Hier finden Sie den gesamten Code:

Lassen Sie uns zuerst die Ergebnisse ansehen.

Besuchen Sie selbst den Shop: HauteTopicByAI — Etsy

Dies war das Ergebnis der erfolgreichen Ausführung des KI-Agenten für das oben genannte Experiment.

- Das Produkt war die Erstellung eines T-Shirt-Designs für unseren Etsy-Shop.

- Marktforschung bedeutete, beliebte und geeignete Themen für ein T-Shirt-Design zu finden.

- Datenanalyse bedeutete, relevante Themen zu identifizieren und quantitativ die beste Idee für das Design zu ermitteln.

- Startideen entwickeln, iterieren, das Design ausarbeiten.

- Im Etsy-Shop veröffentlichen. So kam ich auf die Idee für mein Experiment:

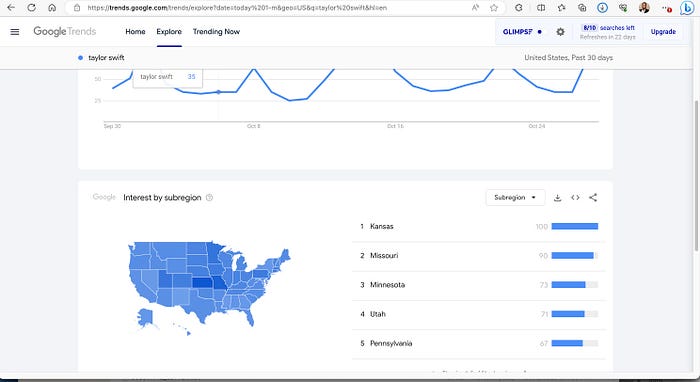

Lassen Sie uns mit den Schritten beginnen, die ich dafür unternehmen musste. In den letzten Wochen gab es in meinem Feed (verschiedene Kanäle, Google News, Reddit und andere Nachrichtenquellen) viel Aufregung um Taylor Swift. Ich analysiere und weiß genug über das Thema, um zu erkennen, dass es populär ist. Ich sollte das allerdings mit quantitativen Daten untermauern. Fangen wir mit Taylor Swift an und schauen uns ihre Google Trends an.

Taylor Swift Google Trends

Wie Sie sehen können, ist der Trend besonders hoch in Kansas. Eine schnelle Internetrecherche ergibt, dass dies das aktuelle Thema Taylor Swift und Travis Kelce ist. Travis Kelce ist ein Footballspieler bei den Kansas Chiefs und Rot eine sehr prägnante Farbe. Unter Berücksichtigung dieser Aspekte und nachdem ich geschaut habe, was es zu diesem Thema schon gibt, konnte ich das „Traylor Shirt“ und Design 1387 erstellen und veröffentlichen.

Lassen Sie uns nun diese Schritte automatisieren und einen KI-Agenten erstellen.

Marktforschung:

Marktforschung wurde oft mit dem Zusammensetzen eines Puzzles verglichen, wobei jedes Puzzleteil einen Einblick in das Verbraucherverhalten, Branchentrends und das Wettbewerbsumfeld darstellt. Traditionelle Methoden, dieses Puzzle zusammenzusetzen, erfordern, dass Datenwissenschaftler durch Massen von Daten wühlen, Analysten stundenlang an Kalkulationstabellen arbeiten und unvermeidlich Besprechungen abgehalten werden, um Strategien auf Basis dieser Forschungsergebnisse zu diskutieren.

In unserem sich ständig weiterentwickelnden digitalen Zeitalter stehen wir jedoch vor einer neuen Herausforderung: der schieren Geschwindigkeit, Vielfalt und Menge an verfügbaren Informationen. Je mehr Daten vorhanden sind, desto größer wird die Notwendigkeit für einen effizienten, umfassenden Ansatz für die Marktforschung. Hier kommt die Leistungsfähigkeit von KI, insbesondere von großen Sprachmodellen (Large Language Models, LLMs) wie OpenAIs GPT-4, ins Spiel. Es gibt aber einen Haken!

LLMs sind unglaublich leistungsfähig. Ihre natürlichsprachlichen Verständnis- und Generierungsfähigkeiten können menschenähnlichen Text produzieren, Kontexte verstehen und sogar kreative Lösungen anbieten. Dennoch haben sie auch Einschränkungen.

Die beiden größten Einschränkungen bisher sind:

- Aktuelle und zeitnahe Daten.

- Fälle von Halluzination.

Wir werden versuchen, diese beiden Themen mit unserem KI-Agenten anzugehen.

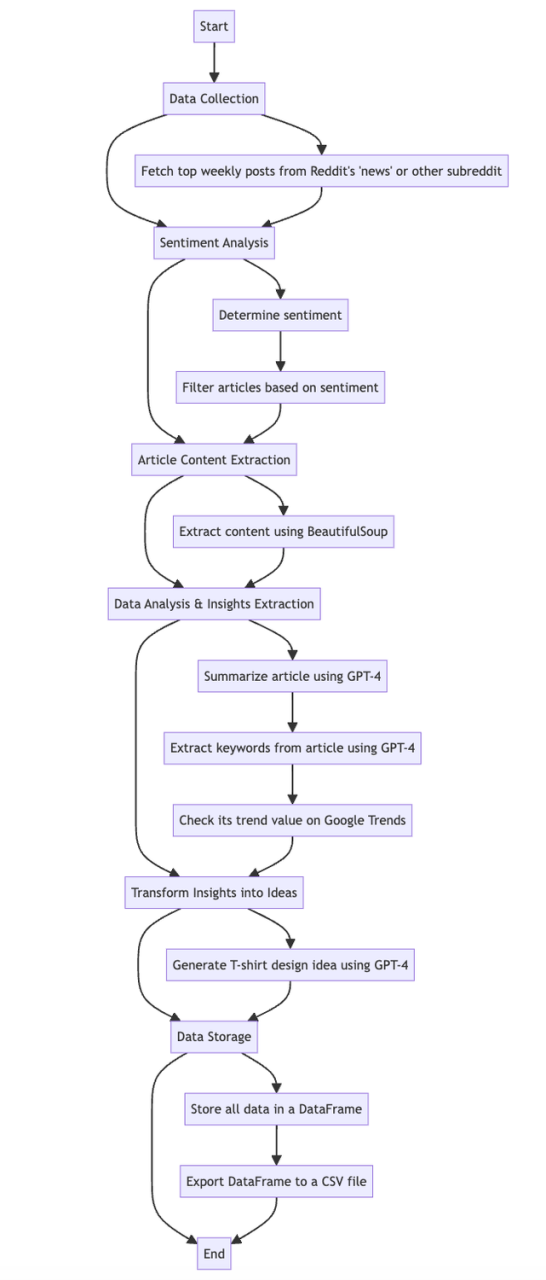

Die Notwendigkeit eines mehrstufigen Ansatzes

Mehrstufiger Prozess zur Erstellung des Agenten

Um die Einschränkungen zu lösen, ist ein mehrstufiger Ansatz erforderlich.

Aktuelle Daten sammeln:

Wir werden versuchen, diese beiden Themen mit unserem KI-Agenten anzugehen.

Zuerst müssen wir aktuelle und zeitnahe Daten erhalten. Dazu nutzen wir die Reddit-API, um die neuesten Informationen aus einem Subreddit unserer Wahl zu beziehen.

# --- Setup API Keys und Reddit Client ---

CLIENT_ID = 'Xg_XXXXXXXXXX' #use your client ID

CLIENT_SECRET = 'XXXXXXXXX'#use your own key

USER_AGENT = 'trending_topic_fetcher'

reddit = praw.Reddit(client_id=CLIENT_ID, client_secret=CLIENT_SECRET, user_agent=USER_AGENT)

# Fetch and filter articles from Reddit

top_week_posts = reddit.subreddit('news').top(time_filter='week', limit=1)

memeworthy_headlines = []

memeworthy_urls = []pyDieser Codeausschnitt zeigt den ersten Schritt: Daten von Reddit beziehen, um sicherzustellen, dass die LLMs mit aktuellen Informationen arbeiten.

Um zu erfahren, wie Sie Ihre eigene Reddit-API einrichten, folgen Sie dem Link in der README.md

Sentiment-Analyse: Der Filterungsmechanismus

Jeder Inhalt hat einen emotionalen Unterton. Um sicherzustellen, dass wir mit Daten arbeiten, die unseren Zielen entsprechen, ist eine Sentiment-Analyse entscheidend.

def get_sentiment(headline):

response = openai.Completion.create(

engine="text-davinci-003",

prompt=f"What is the sentiment of this headline? Positive, neutral, or negative? I am trying to make an upbeat t-shirt design positive is anything that fits the objective. If you are unsure put it under neutral and if you feel it is not a good fit make it negative \"{headline}\"",

max_tokens=1000

)

sentiment = response.choices[0].text.strip().lower()

return sentimentDiese Funktion nutzt die Fähigkeiten von GPT-4, um die Stimmung einer gegebenen Überschrift einzuschätzen.

Datenextraktion durch Web-Scraping

Nachdem wir die Themen kategorisiert haben, können wir Tools wie BeautifulSoup nutzen, um Daten aus dem Artikel oder dem jeweiligen Thema zu extrahieren. Die Leistungsfähigkeit von LLMs ermöglicht ein tiefgehendes Verständnis der extrahierten Daten.

def fetch_article_content(url, headline):

try:

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'}

page = requests.get(url, headers=headers)

soup = BeautifulSoup(page.content, 'html.parser')

article_text = ' '.join([p.get_text() for p in soup.find_all('p')])

return article_text

except requests.RequestException:

print(f"Error fetching article for URL: {url}. Using headline as the content.")

return headline # return the headline if there's an error fetching the articleDie obige Funktion sollte uns robuste Ergebnisse von der Web-URL liefern.

Tiefer in die Datenanalyse eintauchen

Sobald unsere Datenquelle etabliert und gefiltert ist, setzen wir die LLMs als unsere primären Datenanalysten ein.

# Extract Keywords

keywords = get_keywords_from_article(article_content)

# Get keyword scores

keyword_scores = [f"{kw}: {check_google_trends(kw)}" for kw in keywords]

def get_keywords_from_article(article):

response = openai.Completion.create(

engine="text-davinci-003",

prompt=f"We are identifying keywords from the below news article. Extract five keywords from the below article in the format of Word1,word2,word3,word4,word5 \n\narticle:{article}",

max_tokens=2000

)

# Sample text from response.choices[0].text

text = response.choices[0].text

text_cleaned = text.replace("\n", "").strip()

keywords=text_cleaned.split(',')

return keywords

#fetch trends for the keywords

def check_google_trends(keyword):

pytrends = TrendReq(hl='en-US', tz=360)

keyword = keyword.strip()

kw_list = [keyword]

try:

pytrends.build_payload(kw_list)

data_region = pytrends.interest_by_region()

mean_region_scores = data_region.mean()

return mean_region_scores[keyword]

except Exception as e:

return 0Hier veranschaulicht der Code, wie wir wichtige Schlüsselwörter aus den Artikeln extrahieren und deren Popularität mit Google Trends überprüfen.

Wir verwenden den Mittelwert, um den Durchschnitt über alle Bundesstaaten der USA zu erhalten. Dann ordnen wir jedem Schlüsselwort die Bewertung von Google Trends zu.

Diese Informationen werden dann verwendet, um Ideen zu generieren.

Analysen in umsetzbare Erkenntnisse umwandeln

Eine der einzigartigen Facetten von TrendsGPT ist die Fähigkeit, Datenerkenntnisse in greifbare Geschäftsideen oder andere Ideen umzuwandeln.

Hier ist eine vertrauenswürdige Möglichkeit, die Prompts mit den zugehörigen Daten zu versehen.

def get_tshirt_ideas(keywords, article_text):

prompt = f"Using the keyword data which has the trending score next to the keyword: {keywords} and the article text: \"{article_text}\", suggest 2 memeworthy t-shirt ideas and also suggest an appropriate picture to go with it"

response = openai.Completion.create(

engine="text-davinci-003",

prompt=prompt,

max_tokens=1500

)

idea = response.choices[0].text.strip()

return idea

# Generate T-Shirt Idea

tshirt_idea = get_tshirt_ideas(keyword_data_str, article_content)Dieser Codebaustein verkörpert die Übersetzung von Marktforschungsergebnissen in potenzielle T-Shirt-Design-Ideen und veranschaulicht die Fähigkeit des Agenten, eine vollumfängliche Datenanalyse und Marktforschung auf Basis tatsächlicher Daten durchzuführen und diese dann in umsetzbare Ergebnisse umzuwandeln.

Bauen Sie es aus und geben Sie das Ergebnis als CSV oder E-Mail mit Step Functions aus.

Durchlaufen Sie jeden Artikel und wiederholen Sie die obigen Schritte.# Loop durch jeden memeworthy Artikel

for headline, url in zip(memeworthy_headlines, memeworthy_urls):

# Artikelinhalt abrufen

article_content = fetch_article_content(url, headline)

# Artikelzusammenfassung erstellen

article_summary = get_article_summary(article_content)

# Schlüsselwörter extrahieren

keywords = get_keywords_from_article(article_content)

# Schlüsselwort-Bewertungen abrufen

keyword_scores = [f"{kw}: {check_google_trends(kw)}" for kw in keywords]

keyword_data_str = ', '.join(keyword_scores)

# T-Shirt-Idee generieren

tshirt_idea = get_tshirt_ideas(keyword_data_str, article_content)

#print(tshirt_idea)

#An DataFrame anhängen

df.loc[len(df)] = [headline, url, article_summary, ', '.join(keywords), keyword_data_str, tshirt_idea]

time.sleep(2) # Verhindert Ratenbegrenzungen

# In CSV speichern (oder Excel, wenn bevorzugt)

df.to_csv('memeworthy_articles.csv', index=False)

Das menschliche Element

So wird die Ausgabe nach einem Beispieldurchlauf aussehen:

Subreddit: News

Hole Artikel von Reddit...

[]

Überschrift: Matthew Perry, Star von 'Friends', stirbt nach angeblicher Ertrinkung, berichtet TMZ | Sentiment: negativ

Überschrift: Behinderter Mann zieht sich selbst aus dem Flugzeug, nachdem Air Canada keinen Rollstuhl anbot | Sentiment: negativ

Überschrift: Zweite Person, die eine experimentelle Schweineherz-Transplantation erhielt, stirbt knapp sechs Wochen nach dem Eingriff | CNN | Sentiment: negativ

Überschrift: Verdächtiger nach 2 Vorfällen mit aktivem Schützen im Gebiet von Lewiston, Maine flüchtig, sagt Sheriff | Sentiment: negativ

Überschrift: Weißes Haus öffnet Bundesfonds von 45 Milliarden Dollar für Entwickler zur Umwandlung von Büros in Wohnungen | Sentiment: positiv

Überschrift: Schussverdächtiger Robert Card in Maine tot aufgefunden, sagen Beamte | Sentiment: neutral

Verarbeite nur positive Artikel

Verarbeite Artikel: Weißes Haus öffnet Bundesfonds von 45 Milliarden Dollar für Entwickler zur Umwandlung von Büros in Wohnungen

Schlüsselwörter

['Biden', 'Wohnen', 'Entwickler', 'Transit', 'Finanzierung', '']

Keyword Trend-Daten

Biden: 0, Wohnen: 3.356, Entwickler: 3.432, Transit: 3.124, Finanzierung: 0, : 0

:

T-Shirt-Idee 1: "Machen wir unsere Städte wieder großartig! Biden, Wohnen, Entwickler & Transit" mit einem Bild einer Skyline mit modernen Wohngebäuden neben Transitknotenpunkten.

T-Shirt-Idee 2: "Finanzierungslösungen für erschwinglichen Wohnraum" mit einem Bild eines Finanzberaters, der das Budget für eine Wohnungsbauprojekt berechnet.Subreddit: NBA

Hole Artikel von Reddit...

[]

Überschrift: Wemby kommt in der Arena an Halloween an | Sentiment: neutral

Überschrift: [Highlight] Steph Curry kocht Dillon Brooks für seinen 4. Dreier in Folge | Sentiment: positiv

Überschrift: [Wojnarowski] BREAKING: Die Philadelphia 76ers haben einem Trade zugestimmt, Guard James Harden zu den Los Angeles Clippers zu schicken, sagen Quellen zu ESPN. | Sentiment: neutral

Überschrift: [Highlight] 🚨 Luka Doncic Bist du verrückt? 🚨 Er hat 4 Clutch-Dreier in Folge getroffen, um auf 49 Punkte zu kommen. | Sentiment: positiv

Überschrift: Chris Broussard fragt, ob James Harden "entwicklungsbehindert" ist | Sentiment: negativ

Überschrift: [Highlight] Andre Drummomd begrüßt Chet in der Liga, indem er seine Knöchel bricht und dunked | Sentiment: positiv

Verarbeite nur positive Artikel

Verarbeite Artikel: [Highlight] Steph Curry kocht Dillon Brooks für seinen 4. Dreier in Folge

Schlüsselwörter

['Keywords:views', '267', '696', '00', '00']

Keyword Trend-Daten

Keywords:views: 0.4, 267: 11.436, 696: 5.392, 00: 0, 00: 4.38

.

T-Shirt-Idee 1: "Siehst du 267? 696 Aufrufe!"

Bild: Ein Bild von Augen in Form der Zahlen 267 und 696.

T-Shirt-Idee 2: "Lass uns die doppelten Nullen treffen!"

Bild: Ein Bild von zwei Nullen nebeneinander.

Verarbeite Artikel: [Highlight] 🚨 Luka Doncic Bist du verrückt? 🚨 Er hat 4 Clutch-Dreier in Folge getroffen, um auf 49 Punkte zu kommen.

Schlüsselwörter

['Luka Doncic', 'Video', 'Anschauen', 'Archiviert', 'Aufrufe']

Keyword Trend-Daten

Luka Doncic: 1.496, Video: 0, Anschauen: 8.836, Archiviert: 8.12, Aufrufe: 6.972

T-SHIRT 1: "LUKA DONCIC BIST DU VERRÜCKT?" mit einem Bild seines überraschten Gesichtsausdrucks

T-SHIRT 2: "198.617 AUFRUFE" mit einem Bild, auf dem er einen Jubeltanz aufführt.Indem Sie diese Startideen sammeln und Tools wie Midjourney und Canva nutzen, können Sie die Idee verfeinern und zu einem fertigen Produkt bringen.

Große Schritte für automatisierte Agenten und ihren Einfluss auf datengesteuerte Analysen

Die Fusion von KI und Datenanalyse, wie im TrendsGPT-Modell gezeigt, repräsentiert möglicherweise die Zukunft der Marktforschung. Durch die Integration praktischer Code-Implementierungen in unsere mehrstufige Methodik stellen wir sicher, dass unser Ansatz nicht nur theoretisch fundiert, sondern auch praktisch effizient ist.

In einer Welt, in der es entscheidend ist, einen Schritt voraus zu sein und sich ein gut recherchiertes Produkt von der Konkurrenz abhebt, sind automatisierte Datenanalysetools wie TrendsGPT, gestärkt durch den richtigen Code,unschätzbare Hilfsmittel, um Ihre Zeit bis zur Fertigstellung zu beschleunigen. Sie sagen uns nicht nur, wo sich der Markt gerade befindet, sondern auch, wohin er sich entwickelt. Und in einer Welt des Wettbewerbs kann diese Geschwindigkeit den entscheidenden Unterschied ausmachen.