Ein Forschungspapier sorgt in der Branche für Aufsehen, und zwar aus einem einzigen Grund:

Die Forscher behaupten, ChatGPT sei Bullshit.

Die wahre Natur der KI

Wenn ein großes Sprachmodell (LLM) etwas falsch macht, sagen wir, das Modell habe „halluziniert“.

Das liegt daran, dass LLMs stochastische (pseudo-zufällige) Wortgeneratoren sind. Es besteht immer eine gewisse Wahrscheinlichkeit, dass das Modell etwas Unerwartetes ausgibt, das von der Wahrheit abweicht.

Und lassen Sie mich klarstellen: Das geschieht mit Absicht.

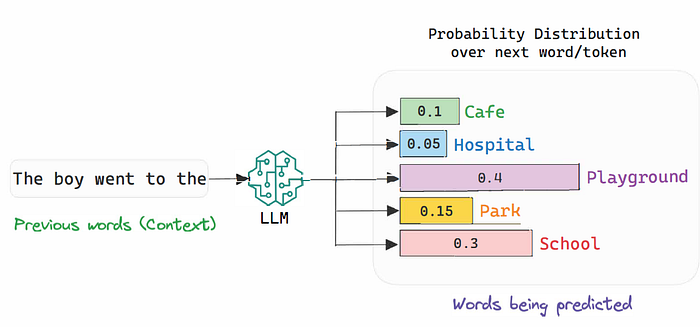

Da es viele Möglichkeiten gibt, denselben Gedanken oder dasselbe Gefühl in natürlicher Sprache auszudrücken, trainieren wir unsere Modelle darauf, Unsicherheit zu modellieren. Dazu lassen wir sie nicht für jede neue Vorhersage ein genaues Wort festlegen, sondern zwingen sie, eine Wahrscheinlichkeitsverteilung über ihren gesamten Wortschatz auszugeben.

Mit anderen Worten, wie unten zu sehen ist, ordnet das Modell die Wörter, die es kennt (den Wortschatz), danach, wie statistisch sinnvoll sie als Fortsetzung der Eingabesequenz sind.

Interessanterweise wählen wir jedoch nicht immer das wahrscheinlichste Wort aus. Tatsächlich wählen wir zufällig eines der k wahrscheinlichsten Wörter aus, da alle wahrscheinlich vernünftige Fortsetzungen sind (im obigen Bild sind alle 5 Optionen semantisch gültig).

Dies geschieht, um die kreative Fähigkeit des Modells zu verbessern, was manchmal wünschenswert ist und von dem man annimmt, dass es die Sprachmodellierungsfähigkeiten des Modells verbessert.

LLMs verfügen über einen Hyperparameter namens „Temperatur“, mit dem Sie steuern können, wie „kreativ“ das Modell sein soll.

Aber wenn das Modell bei diesem Prozess etwas falsch macht und eine abwegige Behauptung ausgibt, „halluziniert“ es dann wirklich so wie Menschen?

Die Vermenschlichung von Robotern

Die Forscher sagen, dass dies eindeutig falsch ist.

Eine Halluzination impliziert eine falsche Wahrnehmung der Welt, die jemanden dazu bringt, Aussagen zu generieren, die nicht in der Realität verankert sind. Aber genau das ist der Punkt:

LLMs sind nicht in der Lage, die Realität wahrzunehmen.

Sie sehen die Realität durch die Linse des Textes, was sie daran hindert, sie wirklich zu erleben.

Dieser Gedankengang würde wahrscheinlich auch davon ausgehen, dass unsere kürzlich diskutierte „Platonische KI“ nicht ganz zutreffend (oder zumindest unvollständig) ist, da den Modellen die Wahrnehmungsfähigkeit fehlt, die Realität zu beobachten: Sie beobachten eine von Menschen generierte Darstellung der Realität (Text und Bilder), was nicht die Realität selbst ist.

Obwohl die Modelle also möglicherweise konvergieren, müssen sie immer noch mit der Fähigkeit ausgestattet werden, die reale Welt zu erfahren.

Aus diesem Grund richtet die Bezeichnung „Halluzination“ mehr Schaden an als sie nutzt. Aber warum nennen wir es nicht einfach Lügen?

Das Ziel von ChatGPT verstehen

Die Forscher stellen auch fest, dass die Behauptung, „ChatGPT habe gelogen“, die wahre Natur von LLMs falsch darstellt. Um zu lügen, muss jemand sich der Wahrheit über etwas bewusst sein und sich bewusst dafür entscheiden, eine alternative ungenaue Aussage zu machen.

Das ist NICHT, was ChatGPT tut.

Tatsächlich argumentiert das Team, dass das Modell sich gar nicht der Wahrheiten und Lügen bewusst sein kann, weil es nicht versucht, die Wahrheit zu sagen; es imitiert einfach nur menschliche Sprache.

Aus diesem Grund trifft der Begriff „Bullshitting“ oder das Verbreiten ungenauer Aussagen, ohne sich ihrer Ungenauigkeit bewusst zu sein, eher auf LLMs zu.

Aber warum?

Insofern das Modell „die Wahrheit spricht“, ist es nur so genau wie die Wahrhaftigkeit seiner Trainingsdaten.

Das Modell bewertet nicht die Wahrhaftigkeit jedes Wortes und jeder Aussage; vielmehr generiert es Antworten auf der Grundlage statistischer Muster und Wahrscheinlichkeiten, unabhängig von deren Wahrheit oder Falschheit.

Mit anderen Worten, für ChatGPT ist es egal, ob zwei Generierungen gleichermaßen statistisch gültig sind, aber eine wahr und die andere falsch ist. Das Modell kümmert sich nicht darum, welche ausgegeben wird, da beide sein Ziel erfüllen, menschliche Sprache angemessen zu imitieren.

Folglich scheint ein Modell zwar aktiv nach der richtigen Antwort auf eine Frage zu suchen, wenn Sie sich mit ihm unterhalten, aber in Wirklichkeit ruft es die Lösung aus seinem eigenen Kernwissen auf der Grundlage der bereitgestellten Eingabesequenz ab; es sucht nicht nach der Wahrheit, sondern nach der statistisch plausibelsten Fortsetzung einer gegebenen Sequenz.

Aber gibt es eine Möglichkeit, Modelle genauer zu machen?

Auf der Suche nach der Wahrheit

Wenn wir davon ausgehen, dass Reasoning eine Form der Suche im Raum möglicher Lösungen ist, bis die richtige gefunden wird (dies scheint nach meiner eigenen Forschung eine akzeptierte Sichtweise zu sein, unabhängig davon, ob LLMs effektiv schlussfolgern können oder nicht, was ein anderes Thema ist), verbessert die Kombination von LLMs mit Laufzeitsuche ihre Reasoning-Fähigkeiten und reduziert somit Ungenauigkeiten.

Allerdings sucht das Modell auch in diesem Modus nicht nach der Wahrheit, da das Ziel weiterhin dasselbe bleibt: die Nachahmung menschlicher geschriebener Sprache.

Allerdings gibt es möglicherweise einen Weg, die Wahrhaftigkeit implizit zu verbessern, etwas, das Forscher seit einiger Zeit auf zwei Arten untersuchen: Entropieminimierung und, in jüngerer Zeit, Test-Time Fine-Tuning.

- Bei der Entropieminimierung hat das Modell eine induktive Verzerrung hin zu Antworten mit geringerer Entropie. Mit anderen Worten, es generiert mehrere Antworten und geht davon aus, dass die Antwort mit der geringsten Anzahl von Annahmen, also die einfachste, die beste Antwort ist, was einige von Ihnen an Ockhams Rasiermesser erinnern wird.

Nehmen wir zum Beispiel an, wir haben ein Modell, das entscheiden muss, ob ein Tier ein Hund ist oder nicht.

- Eine Antwort mit niedriger Entropie wäre: „Es ist ein Hund, weil es bellt.“

- Eine Antwort mit hoher Entropie wäre: „Es ist ein Hund, weil es mit einer Intensität von 80 dB und in einem Winkel von 87 Grad zu mir bellt“.

Beide sind korrekt, aber die erste ist besser, weil das Bellen eine ausreichende Bedingung ist, um zu entscheiden, dass es sich um einen Hund handelt (auch junge Wölfe bellen, aber Sie verstehen den Punkt).

Die zweite Antwort, obwohl wahr, ist auf eine sehr spezielle Instanz eines bellenden Hundes überangepasst, was das Modell zu der Annahme verleiten könnte, dass bellende Tiere mit geringerer Lautstärke oder einem anderen Winkel keine Hunde sind.

- Beim Test-Time Fine-Tuning suchen Jack Cole und Mohamed Osman aktiv nach einer Lösung für den berühmten ARC-AGI-Benchmark (der schwierigste Benchmark für LLMs), indem sie das Modell während der Inferenz feinabstimmen.

Hier generiert das Modell, wenn es mit einem komplexen Problem konfrontiert wird, mehrere Lösungen dafür, findet die richtige und stimmt die Gewichte des Modells in Echtzeit ab.

Dies ist eine Form des aktiven Lernens, bei der das Modell in der Lage ist, sich an das vorliegende Problem anzupassen, was bedeutet, dass es nie aufhört zu lernen.

Meiner bescheidenen Meinung nach (ich könnte mich sehr wohl irren) lösen diese sehr spannenden Ansätze zur Kombination von Suche und LLMs, obwohl sie die Genauigkeit eines Modells zu verbessern scheinen, immer noch nicht das Problem, dass das Modell im Wesentlichen immer noch nicht nach der Wahrheit sucht, sondern die beste, statistisch vernünftige Antwort liefert, die den zuvor memorierten Lösungswegen ähnelt.

Mit anderen Worten, während intelligentere Suchmethoden und LLMs zu besseren, faktisch genaueren Antworten führen könnten, erfüllt das Modell immer noch nur sein Ziel, die statistisch plausibelste Antwort zu liefern, ohne jegliche Rücksicht auf die Wahrhaftigkeit der Antwort, auch wenn verbesserte induktive Verzerrungen wie die diskutierten die Wahrhaftigkeit implizit verbessern können.

Tatsächlich können meiner Meinung nach Wahrheitssuche und Handlungsfähigkeit nicht getrennt werden; daher können aktuelle Modelle nicht nach der Wahrheit suchen. Mit anderen Worten, meiner Ansicht nach brauchen wir KI-Modelle, die nicht nur aktiv unsere Welt erleben (Verkörperung), um die Konsequenzen ihrer Handlungen zu verstehen, sondern sie müssen auch mit einer Reihe von „Tugenden“ ausgestattet werden, die das Modell dazu bringen, die Wahrheit als sein Hauptziel zu betrachten.

Kurz gesagt, selbst in diesen Fällen habe ich immer noch das Gefühl, dass das Modell Bullshit produziert.

Die Dinge beim richtigen Namen nennen

Bevor wir die Frage der Handlungsfähigkeit diskutieren, sollten wir beantworten, ob LLMs Bedeutung verstehen, aber wie Brown-Forscher gezeigt haben, können wir das immer noch nicht.

Natürlich kann man argumentieren, dass mit der Verarbeitung qualitativ hochwertigerer Daten und der Verbesserung der Komprimierungsfähigkeit unserer Modelle „wahre“ Aussagen für das Modell statistisch vernünftiger werden als „falsche“.

Jedoch werden solange die Modelle nicht in der Lage sind, nach der Wahrheit zu suchen (weil sie sich ihrer Existenz nicht bewusst sind), unterrepräsentierte Wahrheiten in den Trainingsdaten dazu tendieren, das Modell dazu zu bringen, zu „halluzinieren“ oder, genauer gesagt, sich in eine falsche Antwort zu „bullshitten“.

Also, wie können wir fortschrittlichen KI-Modellen den Wunsch verleihen, nach der Wahrheit zu suchen?

Ich weiß es nicht. Wissen Sie es?