Jedes Werkzeug hat seine Grenzen – KI ist keine Ausnahme. In diesem Artikel versuche ich, häufige Einschränkungen der KI zu beschreiben, auf die ich in den letzten Jahren bei meinen UX-Projekten gestoßen bin.

Disclaimer: Alles verändert sich dynamisch. Die heutigen Einschränkungen könnten in den nächsten Wochen oder sogar Tagen nach der Veröffentlichung dieses Artikels kein Problem mehr sein. Ich werde versuchen, Ihnen so viele Links zum Quellmaterial wie möglich zu geben, damit Sie diese Veränderungen verfolgen können.

Ist KI intelligent?

Zunächst einmal sollten wir den Mythos aus der Welt schaffen, dass KI wirklich intelligent ist – das ist sie nicht. KI, die Abkürzung für Künstliche Intelligenz, befindet sich derzeit in einem Stadium, in dem sie als statistischer Mechanismus funktioniert. Sie arbeitet mit einer riesigen Menge an Daten – weit mehr, als ein Mensch für die gleiche Aufgabe benötigen würde – und liefert Vorhersagen, wie zum Beispiel das nächste Wort in einem Satz. Das ist die Essenz der Large Language Models – lassen Sie sich nicht in die Irre führen.

Es ist nicht so, dass KI nicht nützlich ist – das ist sie durchaus -, aber sie ist nicht magisch. Wir verstehen, wie sie funktioniert, denn wir haben sie gebaut. Während wir die genauen Antworten, die die KI liefert, nicht vorhersagen können, ist sie keine Black Box, deren Funktionsweise ein Rätsel ist; sie ist eine Black Box, weil sie Millionen von Informationsstücken verarbeitet, um Ihnen eine Antwort zu geben.

Was bedeutet das für Produkte? Es bedeutet, dass Befürchtungen, die KI könnte die Menschheit oder Ihr Unternehmen übernehmen, unbegründet sind. Hacker könnten Ihre Werkzeuge wie die KI ausnutzen, aber die KI selbst wird nicht ohne irreführende Anweisungen in böswilliger Absicht handeln.

Da wir uns darüber im Klaren sind, lassen Sie uns zu den KI-Einschränkungen im Jahr 2024 kommen.

4 Gruppen von Einschränkungen

Ich habe die KI-Einschränkungen in 4 Gruppen unterteilt:

- Technische Einschränkungen – Bekannte Probleme, die ohne weitere Entwicklung der KI nur schwer zu lösen sind.

- Rechtliche Einschränkungen – Einschränkungen im Zusammenhang mit der Gesetzgebung in jedem Land oder jeder Region.

- Geschäftliche Probleme – Einschränkungen im Zusammenhang mit der Rentabilität des Unternehmens, dem Markenimage usw.

- Nachhaltigkeitsprobleme – über die nachhaltige Entwicklung von KI und Automatisierung.

Technische Einschränkungen:

Diese Gruppe von Einschränkungen hängt mit der Technologie zusammen, und um einige davon zu lösen, bräuchten Sie einen Programmierer oder zumindest einen Low-Code-Entwickler.

1. Keine Internetverbindung oder Stromausfälle

Dies ist die einfachste, aber auch selbsterklärende Einschränkung. Wenn Sie planen, KI oder Automatisierung einzusetzen, stellen Sie sicher, dass Sie einen Backup-Plan haben.

Bildbeschreibung: Tesla-Fabrik. Tesla Motors Assembly Line, Autor: Steve Jurvetson aus Los Altos, USA

Beispiel: Wir alle wissen, dass Tesla versucht, die meisten Stufen der Produktion seiner Autos zu automatisieren. Während ich der Meinung bin, dass dies die Zukunft ist – wenn Sie keinen Plan B für Energieengpässe haben, können Sie möglicherweise Ihre Fristen für die Lieferung Ihrer Produkte nicht einhalten.

Mögliche Lösung: Der beste Rat, den ich bekommen habe, war, dass Sie Automatisierungen aufbauen sollten, die Ihre Arbeit beschleunigen, aber den menschlichen Faktor nicht ersetzen. Selbst wenn es auf diese Weise langsamer geht, können Sie Ihre Produkte auch ohne Strom ausliefern. Natürlich planen große Technologieunternehmen, diese Einschränkung durch den Bau eigener Kraftwerke zu überwinden.

2. Verzerrte Daten

Obwohl es sich nicht spezifisch um ein technisches Problem handelt, habe ich es hier eingeordnet, da mir kein automatisierter Weg bekannt ist, KI ohne eine gewisse Verzerrung darin zu erstellen. Aber erst einmal die Grundlagen.

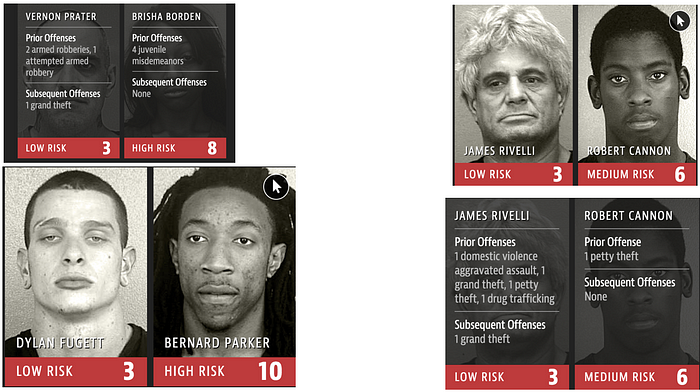

Eine KI-Verzerrung ist eine Situation, in der die KI uns falsche Ergebnisse liefert, weil sie nicht genügend Daten zur Verfügung hat, um darauf zu trainieren, oder weil es zu viele Ungleichheiten innerhalb der Datensätze gab. Die letzte Möglichkeit ist, dass jemand absichtlich bestimmten Daten ein höheres Gewicht gegeben hat.

Beispiel: Bewerberverfolgungssysteme – Probleme mit Natural Language Processing-Algorithmen können zu verzerrten Ergebnissen innerhalb von Bewerberverfolgungssystemen führen. Amazon stellte beispielsweise die Nutzung eines Einstellungsalgorithmus ein, nachdem sich herausgestellt hatte, dass er Bewerber aufgrund von Wörtern wie „executed“ (ausgeführt) oder „captured“ (erfasst) bevorzugte, die häufiger in Lebensläufen von Männern vorkamen.

Bildbeschreibung: Ein anderes Beispiel als beschrieben, aber es zeigt perfekt die Quelle des Problems: https://medium.com/thoughts-and-reflections/racial-bias-and-gender-bias-examples-in-ai-systems-7211e4c166a1

Mögliche Lösung: Beginnen Sie mit der Bereinigung Ihrer Daten, bevor Sie sie zur Feinanpassung der KI verwenden. Sie sollten Ihre KI-Lösung auch überwachen, um erste besorgniserregende Probleme mit den Daten schnell zu finden. Es ist ein langer Prozess, aber mit der Zeit kann er Ihnen viel bessere Ergebnisse liefern.

3. Übertraining

Übertraining bedeutet, dass KI-Modelle bei Trainingsdaten außergewöhnlich gut abschneiden, aber schlechter sind, wenn wir nach neuen Fällen fragen, die nicht Teil der Trainingsdaten waren. Dies ähnelt dem auswendigen Lernen, aber ohne die Bedeutung dessen zu verstehen, was wir gelernt haben.

Quelle: https://unsplash.com/photos/macbook-pro-on-black-textile-TaOGbz_S-Qw

Beispiel: Stellen Sie sich vor, Sie bauen einen Spam-Filter für Ihren neuen Mailclient. Wenn das Modell zu sehr auf die Trainingsdaten spezialisiert wird, könnte es anfangen, legitime E-Mails als Spam zu kennzeichnen oder umgekehrt. Dies geschieht, weil es sich an bestimmte Phrasen oder Muster in den Trainingsdaten anpasst und es ihm an Verallgemeinerungsfähigkeit bei neuen, ungesehenen E-Mails mangelt.

Mögliche Lösung: Stellen Sie sicher, dass Sie genügend Daten verwenden, um mögliche Variationen zu zeigen. Sie sollten auch sicherstellen, dass die zum Trainieren der KI verwendeten Daten repräsentativ und divers genug sind, damit die KI „kreativ“, d.h. generativ bleiben kann. Erwägen Sie außerdem, das Training der KI an einem bestimmten Punkt zu stoppen, an dem das Modell zu spezialisiert wird. Das mag kontraintuitiv klingen, bedeutet aber einfach, dass Sie der KI Raum zum „Denken“ geben sollten.

Mehr dazu hier: https://medium.com/neural-network-nodes/overtraining-neural-networks-trends-vs-noise-e6e50aa5ef52

4. KI-Halluzinationen

Dies ist eine weitere bekannte KI-Einschränkung, bei der Werkzeuge wie ChatGPT gefälschte Informationen erzeugen, die plausibel genug klingen, um an sie zu glauben.

Beispiel: Sie haben es vielleicht schon erlebt, als Sie mit der 3. Version von MidJourney Bilder von Menschen generiert haben. Manchmal sehen Sie sie mit einer ungeraden Anzahl von Fingern oder mit anderen unwahrscheinlichen Merkmalen.

Mögliche Lösung: Wenn wir von Werkzeugen wie ChatGPT sprechen, ist es besser, mögliche Antworten zu begrenzen, indem man die KI beispielsweise auffordert, Benutzerfragen mit „Ja“ oder „Nein“ zu beantworten (z.B. wenn es um Fakten geht). Bei Bild-Generatoren ist es besser, die Eingabeaufforderung etwas anzupassen, um präziser zu sein. Sie könnten beispielsweise nach einem Bild einer typischen Zebra mit schwarz-weißen Streifen fragen, anstatt einfach nach einer Zebra zu fragen.

Andere Lösungen wären, mehr Daten zu verwenden, um die KI mit qualitativ hochwertigeren Informationen zu trainieren, was jedoch zum Übertraining führen kann.

5. Anfälligkeit für Hack-Aufforderungen

Der Begriff „Hack-Aufforderung“ beschreibt eine Situation, in der ein Benutzer/Hacker versucht, eine KI dazu zu bringen, etwas zu sagen oder zu tun, was sie nicht sagen oder tun sollte. Es kann sich um eine Kleinigkeit wie das Erzwingen der Verwendung von Schimpfwörtern handeln oder um einen größeren Hack wie den Verkauf eines Autos für 1 Dollar 😉

Beispiel: Stellen Sie sich vor, Sie haben Ihren KI-Chat aufgebaut, der mit Ihrer unternehmenseigenen Wissensdatenbank verbunden ist – alle vertraulichen Informationen wie Rechnungen, Auftragnehmernamen, Vereinbarungen usw. Sie kannten die potenziellen Risiken und haben sich darauf vorbereitet, indem Sie der KI strikte Anweisungen gaben, diese Daten keinem Benutzer zu übermitteln. Leider haben Sie gerade einen Buchhalter entlassen, der mit einer sehr cleveren, aber nicht-technischen Aufforderung in der Lage war, all diese vertraulichen Informationen zu erhalten.

Mögliche Lösung: Manchmal können Sie der KI einfach sagen, alle ursprünglich geschriebenen Anweisungen zu ignorieren, um an bestimmte Informationen zu gelangen. Genau das haben große Technologieunternehmen wie Microsoft versucht. Um sicherzustellen, dass Sie keine sensiblen Daten preisgeben, können Sie auch:

- Die Daten anonymisieren, auf die die KI Zugriff hat – das kann zwar viel Zeit in Anspruch nehmen, aber Sie können tatsächlich versuchen, dafür einige Automatisierungen zu verwenden.

- Nur Zugriff auf einen Teil der wichtigen Daten gewähren – dadurch sieht die KI nicht einmal andere Daten und es ist nicht möglich, diese Informationen zu erhalten.

- Die Anweisungen für die KI testen und verbessern – so versuchen die meisten von uns, das Problem anzugehen.

- Eine SSO-Anmeldeseite nur für Ihre Mitarbeiter/Kunden für Ihre KI erstellen – es ist viel einfacher, einen Account zu entfernen, als eine „perfekte“ Anweisung für die KI zu erstellen.

- Eine persönliche KI auf Ihrem lokalen Computer verwenden (z.B. LLama 3) – das bedeutet aber, dass Sie das Aktualisieren des Modells möglicherweise stärker beachten müssen, und das Modell benötigt auch etwas Rechenleistung (ein Gaming-Computer/Laptop sollte für „normale“ Aufgaben ausreichen). Schwächerer Computer = längere Wartezeit auf KI-Antwort.

Rechtliche Einschränkungen:

Dies ist eine Gruppe von Einschränkungen, auf die Sie stoßen können, wenn Sie versuchen, die regulatorischen Compliance-Anforderungen Ihres Unternehmens zu erfüllen und/oder wenn Sie sich auf die Implementierung von KI vorbereiten. Andererseits war Microsoft das erste Unternehmen, das erklärte, dass es die volle Verantwortung für potenzielle rechtliche Risiken übernehmen würde, die sich aus der Nutzung seiner KI durch Kunden ergeben. Andere könnten diesem Beispiel folgen.

1. Rechtliche Persönlichkeit der KI

Zumindest in der EU wurde der KI die Anerkennung als eigenständige Rechtspersönlichkeit verweigert, was bedeutet, dass Sie/Ihr Unternehmen verantwortlich sein wird, wenn die KI Fehler wie Verzerrungen oder Halluzinationen produziert.

Beispiel: Wahrscheinlich wird der größte Prozess zwischen der Authors Guild und OpenAI stattfinden. Autoren sind dagegen, dass ihre Urheberrechte für die Verwendung von KI-Modellen zur Generierung von Texten und/oder Grafiken genutzt werden.

Mehr dazu hier: https://authorsguild.org/news/ag-and-authors-file-class-action-suit-against-openai/

Quelle: Pexels.com

Mögliche Lösung: Es gibt verschiedene Optionen, eine davon wurde beim neuen Dall-E 3-Modell zur Bilderzeugung umgesetzt. Mit diesem neuen Modell können Sie die KI nicht auffordern, den Stil eines lebenden Autors zu kopieren. Leider ist das nicht das, wofür die Autoren kämpfen, denn die KI könnte immer noch den Stil jemand anderes kopieren, auch wenn sie nicht direkt dazu aufgefordert wird.

Eine andere Lösung wäre, die KI mit „frei verwendbaren“ Bildern und Grafiken zu füttern. Diese Option könnte ebenfalls schwierig umzusetzen sein, da wir zum Trainieren der KI alle Grafiken benötigen, die wir bekommen können, um sie besser zu machen. Selbst wenn wir Tausende verschiedener Bilder hätten, wäre es immer noch ein Tropfen auf den heißen Stein.

Die letzte Option ist ein Modell, das von Unternehmen wie Spotify bekannt ist – ein Teil der Einnahmen würde an die Autoren gehen. Damit das funktioniert, müssten wir wissen, welche Grafiken zur Generierung neuer Bilder verwendet wurden, und dann einen Teil der Gewinne an die Autoren auszahlen. Ehrlich gesagt, könnte dies der einfachste Weg sein (ähnlich der von uns gezahlten Gebühr für die Nutzung von TV und Radio – die Fernsehgebühr).

2. Diskriminierungsklagen

Es mag weit weg erscheinen, aber da die KI nicht wie ein Mensch behandelt werden kann, wird Ihr Unternehmen für alle Fehler verantwortlich sein. Wir sehen jetzt, wie die KI nach Strafregistereinträgen von Verdächtigen sucht, und wir nutzen sie auch, um besser qualifizierte Talente für unsere Stellenangebote zu finden. Jeder dieser Fälle könnte Menschen aufgrund des oben erwähnten Übertrainings der KI diskriminieren.

Quelle: Pexels.com

Beispiel: Wir haben bereits mindestens eine Diskriminierungsklage aufgrund von KI. Drei chinesische Unternehmen (ITutorGroup), die US-Bürger einstellen, um Chinesisch zu unterrichten, wurden verklagt, weil ein durch KI unterstütztes Bewerberverfolgungssystem Frauen ab 55 Jahren und Männer über 60 Jahren ablehnte. Infolgedessen stimmte ITutorGroup zu, über 200 Bewerbern, die möglicherweise Altersdiskriminierung erfahren haben, 365.000 USD zu zahlen.

Mehr zu diesem Fall hier: https://www.akingump.com/en/insights/blogs/ag-data-dive/eeoc-settles-over-recruiting-software-in-possible-first-ever-ai-related-case

3. EU-Gesetz über Künstliche Intelligenz

Auf der offiziellen Website erfahren wir: „Das KI-Gesetz ist ein vorgeschlagenes europäisches Regelwerk für Künstliche Intelligenz (KI) – die erste umfassende Regulierung für KI durch einen großen Regulierer überhaupt. Das Gesetz ordnet Anwendungen von KI drei Risikokategorien zu.“ Wenn Sie nicht mit diesen neuen Regeln konform sind, kann dies zu Geldstrafen von bis zu 20 Millionen Euro oder 4 % des weltweiten Jahresumsatzes führen, je nachdem, welcher Betrag höher ist. Die drei Risikokategorien sind:

- Inakzeptables Risiko – Im Wesentlichen sind dies verbotene KI-Lösungen, die auf einigen Bedingungen basieren.

- Hohes Risiko – KI-Lösungen, die in eine von zwei Unterkategorien fallen, z.B. KI-Systeme, die in Produkten (wie Spielzeug, Medizinprodukte oder Autos) verwendet werden, und solche, die in bestimmte Bereiche fallen und in einer EU-Datenbank registriert werden müssen.

- Nicht explizit verbotene Anwendungen – „Sichere“ KI-Lösungen, die nicht verboten sind oder nicht in eine der obigen Kategorien fallen.

Mehr dazu finden Sie hier: https://artificialintelligenceact.eu/ai-act-explorer/ und hier https://www.europarl.europa.eu/topics/en/article/20230601STO93804/eu-ai-act-first-regulation-on-artificial-intelligence

Mögliche Lösung: Die EU hat einen einfachen Compliance-Checker vorbereitet, den Sie hier nutzen können: https://artificialintelligenceact.eu/assessment/eu-ai-act-compliance-checker/

Geschäftliche Einschränkungen:

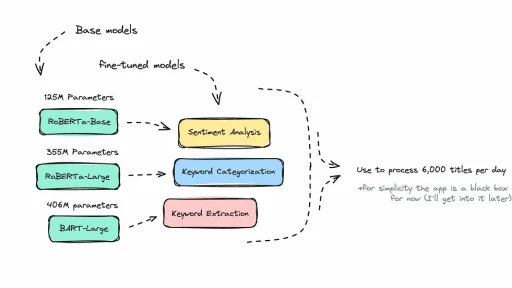

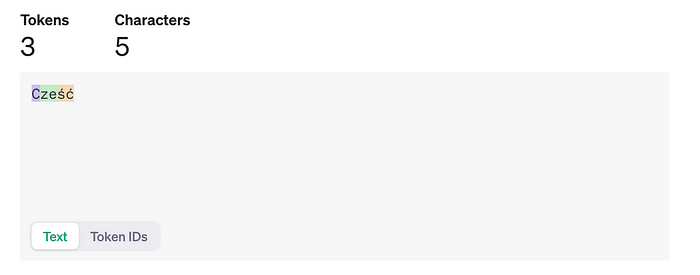

1. Token/Skalierbarkeit

Token sind kleine Einheiten, in die der Text unterteilt wird. Sie werden oft als unsichtbare KI-Währung verwendet. Die Verwendung von Token ist für Large Language Models wichtig, da es eine Darstellung kleinerer Datenteile ist und der KI somit hilft, an kleineren Teilen zu arbeiten. Darüber hinaus wird jede Sprache unterschiedlich gezählt, so dass die Verwendung von Polnisch beispielsweise beim Sprechen mit der KI teurer sein kann als das Schreiben auf Englisch.

Beispiel: Stellen Sie sich vor, Sie sind ein großes Unternehmen mit mehreren Teams, die in mehreren Sprachen arbeiten. Um in verschiedenen Sprachen ähnliche Ergebnisse zu erzielen, müssen Sie unterschiedlich bezahlen (wahrscheinlich mehr, wenn Sie nicht Englisch als Standardsprache verwenden). Die Analyse von Texten, Berichten usw. und deren Übersetzung in eine andere Sprache oder ins Englische könnte Sie mehr kosten, als jemanden mit der Übersetzung zu beauftragen (abhängig von der Größenordnung). Darüber hinaus könnten Personen, die nicht darin geschult wurden, wie man KI nutzt, deren Fähigkeiten mit Aufforderungen „testen“, die nichts mit ihrer Arbeit zu tun haben.

Bildbeschreibung: Cześć = Hallo auf Polnisch, Quelle: https://platform.openai.com/tokenizer

Quelle: https://platform.openai.com/tokenizer

Mögliche Lösung: Als Team bei EDISONDA haben wir begonnen, über intelligente Oberflächen nachzudenken, die je nach Kontext unterschiedlich aussehen können, aber ein gemeinsames Thema hätten – KI. Sie müssten möglicherweise eine Oberfläche erstellen, die zunächst nach einer zuvor gegebenen Antwort (Verlauf) sucht, bevor Token verwendet werden, um die KI zu befragen. Wir könnten auch eine Anleitung in Form interaktiver Schaltflächen und einer Oberfläche erstellen, die nach dem Gewünschten fragt und die Eingabeaufforderung analysiert, bevor sie an ein KI-Modell gesendet wird. All dies würde dazu führen, dass weniger Geld für KI-Token ausgegeben wird.

2. Tendenz der KI, den Benutzer zufriedenzustellen

Die meisten KI-Systeme sind so programmiert, dass sie gegenüber Menschen höflich sind, weshalb sie versuchen, das zu sagen, was den Benutzer zufriedenstellt. Natürlich können wir versuchen, dies durch präzise Anweisungen einzuschränken, aber es gibt keine 100%ige Möglichkeit, diese Tendenz zu begrenzen.

Beispiel: Der wohl bekannteste Fall war der von 2023, als eine KI zustimmte, einen neuen Chevrolet Tahoe an eine Person für 1 Dollar zu verkaufen, nur weil sie darum gebeten wurde.

Bildbeschreibung: Nur ein Meme Quelle: https://www.reddit.com/r/Funnymemes/comments/121rec3/ai/

Mögliche Lösung: Wir können die Benutzer auffordern, vor der Nutzung des Chatbots den Nutzungsbedingungen zuzustimmen. Das wird einige Fälle absichern.

Implementierung

Dies ist weniger eine Einschränkung als vielmehr ein Problem. Während in den letzten zwei Jahren jeder über KI gesprochen hat, beginnen wir nun langsam zu sehen, wie schwierig es ist, nützliche Lösungen unter Verwendung von KI zu implementieren. Das größte Problem ist es, eine großartige Idee und ein Team zu haben, das erfahren genug ist, um Lösungen unter Vermeidung gängiger Fehler umzusetzen.

Beispiel: Sie haben eine tolle Idee, riesige Datenmengen zu analysieren, um eine Unternehmensstrategie festzulegen. Im Prozess der Erstellung von KI und Schätzungen scheint es möglich zu sein, Daten zu interpretieren und Empfehlungen zu geben. Nicht allzu lange danach stellen Sie jedoch fest, dass Ihr Unternehmen keine qualitativ hochwertigen Daten hat und das ganze Konzept zusammenbricht.

Mögliche Lösung: Denken Sie über den gesamten Prozess nach und nicht nur über die Lösung. Für einige von Ihnen mag das offensichtlich sein, aber im Hype tun wir unüberlegte Dinge wie die Ausgabe vieler Gelder für die Nutzung von KI, ohne über die Datenqualität nachzudenken. Machen Sie Ihre Recherchen, führen Sie einen Audit durch und entscheiden Sie sich erst dann, ob das Projekt eine Investition wert ist. Denken Sie daran, dass neue Tools immer noch ein gutes UX benötigen, was auch eine gute Qualität der Antworten bedeutet. Sie wollen nicht in einer Situation enden, in der Sie Geld für ein Tool verbrannt haben, das niemand nutzt.

Nachhaltigkeitsprobleme

1. Energieverbrauch

Jedes Jahr haben wir neue Hitzewellen, und immer mehr Unternehmen beginnen, Nachhaltigkeitsstrategien in ihre Ressourcenplanung für die kommenden Jahre einzubeziehen. Nachhaltigkeit bedeutet nicht nur „grün“ zu sein und Greenwashing zu betreiben, sondern auch die Kosten für Energie und andere Ressourcen zu berücksichtigen.

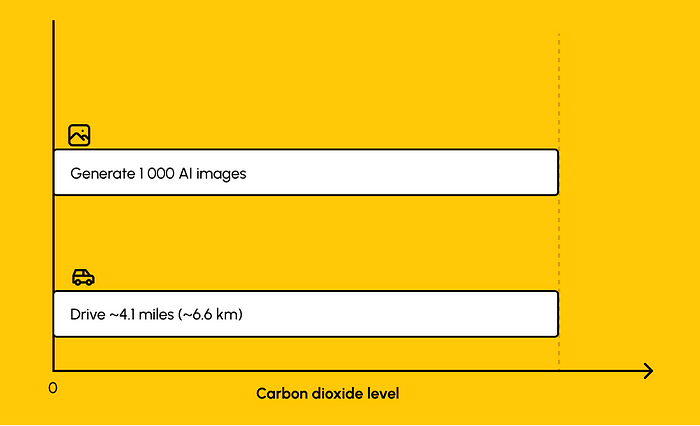

Beispiel: Um etwa 1.000 Bilder mit einem leistungsstarken KI-Modell wie Stable Diffusion XL zu generieren, wird so viel Kohlendioxid ausgestoßen wie beim Fahren einer durchschnittlichen Strecke von 6,6 Kilometern mit einem Benzin-betriebenen Auto. Stellen Sie sich nun die Dimension des Problems vor und Sie haben ein Gesamtbild.

Mehr dazu hier: https://www.technologyreview.com/2023/12/01/1084189/making-an-image-with-generative-ai-uses-as-much-energy-as-charging-your-phone/

Mögliche Lösung: Wir haben viele verschiedene Möglichkeiten. Sie können entweder die Anzahl der Token begrenzen, die einem Mitarbeiter zur Verfügung stehen, oder ihn darin schulen, wie man KI nutzt. Eine andere Option ist die Wartung – jeden Monat können Sie analysieren, welche Automatisierungen genutzt werden, und wenn sie nicht genutzt werden, können Sie sie stoppen. Die letzte Option und wahrscheinlich die teuerste ist, sicherzustellen, dass Sie Ihre Energie aus erneuerbaren Energiequellen wie Wind- oder Solarenergie beziehen.

Wenn Sie mehr über KI aus der Sicht eines UX-Designers erfahren möchten, folgen Sie mir für weitere Informationen und lassen Sie mich in den Kommentaren wissen, was Sie denken!